Filósofo investiga as ideias de automação – do Intelecto Geral de Marx ao ChatGPT. Para ele, o capital não visa eliminar trabalho humano, mas subjugá-lo. E contra corpos que viram fábricas, é possível uma cultura de invenção que vise o coletivo

Por Matteo Pasquinelli | Tradução: Leonardo Foletto e Leonardo Palma

No final de 2023, não lembro onde nem como, fiquei sabendo de The Eye of the Master, novo livro do Matteo Pasquinelli sobre IA. Fiquei na hora empolgado. Primeiro porque a proposta do livro é a de contar uma “história social” da IA, indo desde Charles Babbage até hoje, passando e destrinchando o conceito de general intellect de Marx (hoje bastante usado nos estudos tecnopolíticos) e a onipresente cibernética, também uma área de estudos bastante retomada nos últimos anos por Yuk Hui, Letícia Cesarino e diversos outros pesquisadores, até chegar as IAs generativas de hoje. Tudo uma abordagem rigorosa, por vezes densa, cheia de referências saborosas, e marxista – com várias aberturas típicas do autonomismo italiano e do pós-operaísmo, influências do autor.

Segundo porque Pasquinelli, professor de filosofia da ciência na Universidade Foscari, em Veneza, tem, ele próprio, um belo histórico em se debruçar nos estudos da filosofia da técnica. Eu o conheci pela primeira vez há cerca de 10 anos atrás, quando o artigo “A ideologia da cultura livre e a gramática da sabotagem” saiu como capítulo do Copyfight, importante livro organizado por Bruno Tarin e Adriano Belisário. Depois, outros textos de Pasquinelli foram publicados em português pelo coletivo Universidade Nômade; um deles, “O algoritmo do PageRank do Google: Um diagrama do capitalismo cognitivo e da exploração da inteligência social geral”, já em 2012 apontava para a exploração da “inteligência social geral” por algoritmos das big techs – o que hoje, com IAs generativas, virou um consenso global.

Ainda estou digerindo a leitura da obra e me debruçando sobre alguns tópicos e referências citados, enquanto espero minha cópia impressa do original chegar para rabiscar e estudar com mais calma. Encharcado de uma saborosa empolgação intelectual, daquelas que nos deixam ao mesmo tempo animado pelas descobertas e ansioso em compartilhar esses achados, fui ao texto que Pasquinelli publicou no E-Flux, em dezembro de 2023, “The Automation of General Intelligence” e traduzi para o português. O texto publicado é uma versão do posfácio do livro, onde o italiano sintetiza alguns pontos da obra e aponta caminhos tanto para a discussão teórica quanto para a disputa ativista. Com a ajuda do amigo Leonardo Palma, busquei traduzir cotejando e adaptando alguns conceitos para o português brasileiro, tentando quando possível trazer referências às obras já publicadas por aqui.

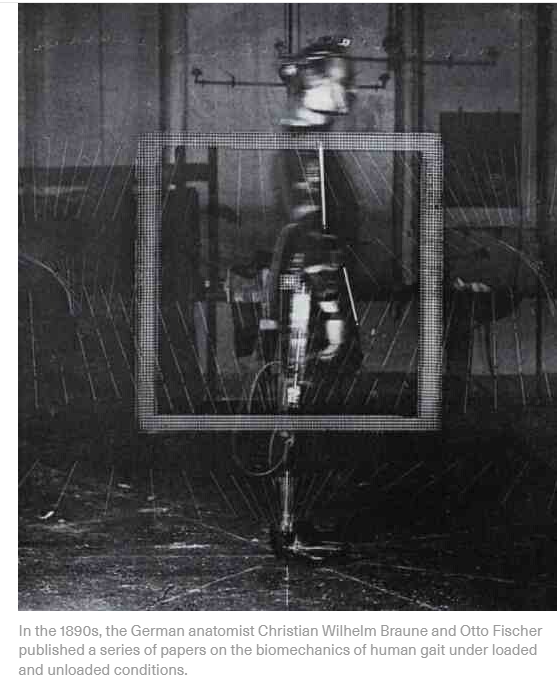

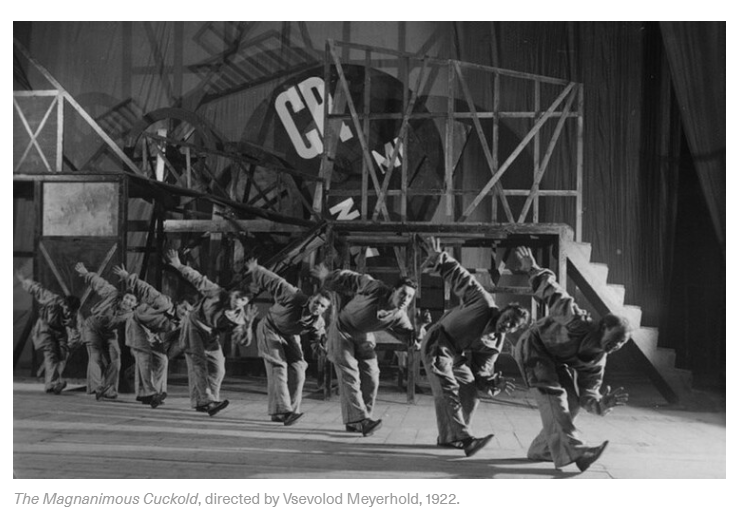

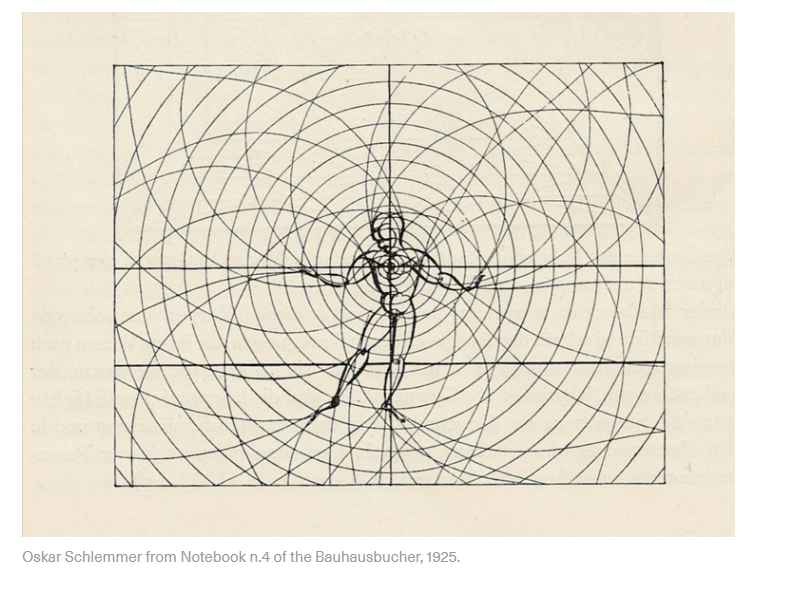

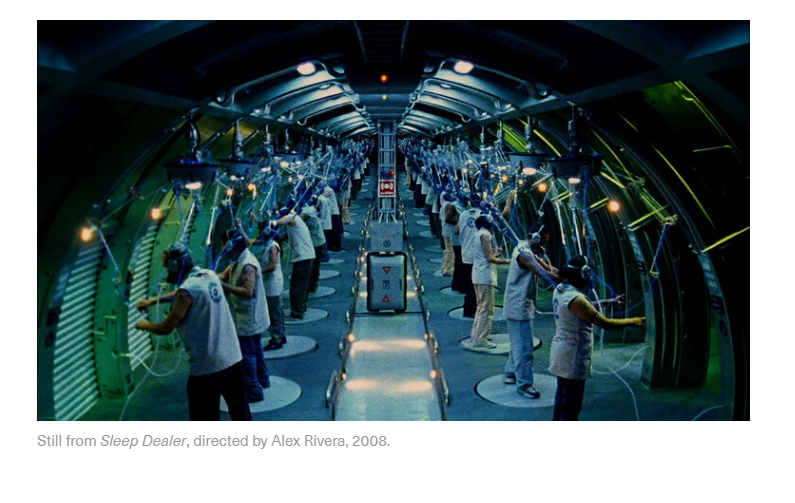

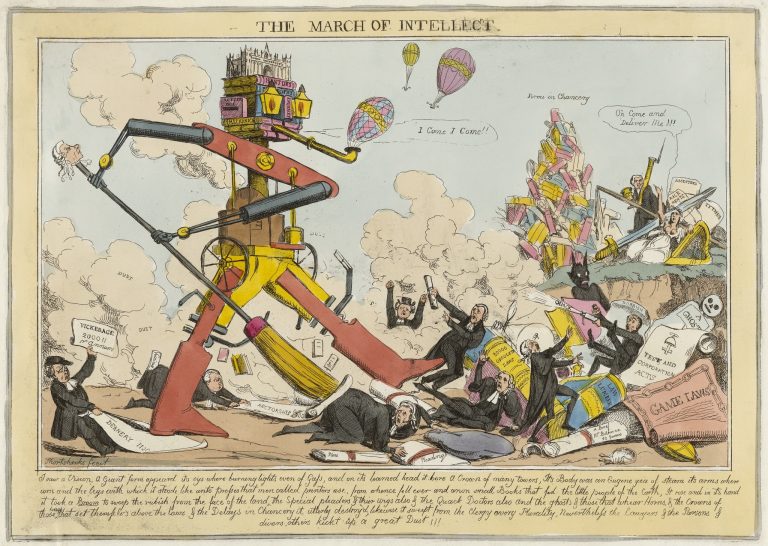

Para acompanhar o texto, trouxe as imagens que ilustram a publicação no E-Flux. Disponibilizo também o livro inteiro em inglês, publicado pela Verso Books (edições em outros idiomas estão vindo) – “The Eye of the Master: A Social History of Artificial Intelligence” – para baixar – mas você sabe, não é para espalhar. [Apresentação: Leonardo Foletto]

A automação da Inteligência geral (General Intelligence)

Por Matteo Pasquinelli

Queremos fazer as perguntas certas.

Como as ferramentas funcionam? Quem as financia e as constrói, e como

são usadas? A quem elas enriquecem e a quem elas empobrecem? Que futuros

elas tornam viáveis e quais excluem? Não estamos procurando respostas.

Estamos procurando por lógica.

—Logic Magazine Manifesto, 2017[¹]

Vivemos na era dos dados digitais e,

nessa era, a matemática se tornou o parlamento da política. A lei

social se entrelaçou com modelos, teoremas e algoritmos. Com os dados

digitais, a matemática se tornou o meio dominante pelo qual os seres

humanos se coordenam com a tecnologia… Afinal, a matemática é uma

atividade humana. Como qualquer outra atividade humana, ela traz consigo

as possibilidades tanto de emancipação quanto de opressão.

—Politically Mathematics manifesto, 2019[²]

“A mesma importância que as relíquias de ossos têm para o conhecimento da organização das espécies de animais extintas têm também

as relíquias de meios de trabalho para a compreensão de formações

socioeconômicas extintas. O que diferencia as épocas econômicas não é “o

que” é produzido, mas “como”, “com que meios de trabalho”. Estes não

apenas fornecem uma medida do grau de desenvolvimento da força de

trabalho, mas também indicam as condições sociais nas quais se

trabalha”.

—Karl Marx, Capital, 1867[³]

Haverá um dia no futuro em que a IA atual será

considerada um arcaísmo, um fóssil técnico a estudar entre outros. Na

passagem de O Capital citada acima, Marx sugeriu uma analogia

semelhante que ressoa nos estudos científicos e tecnológicos atuais: da

mesma forma que os ossos fósseis revelam a natureza das espécies antigas

e os ecossistemas em que viviam, os artefatos técnicos revelam a forma

da sociedade que os rodeia e gere. A analogia é relevante, penso eu,

para todas as máquinas e também para a aprendizagem automática, cujos

modelos abstratos codificam, na realidade, uma concretização de relações

sociais e comportamentos coletivos, como este livro tentou demonstrar

ao reformular a teoria laboral da automação do século XIX para a era da

IA.

Este livro [O Olho do Mestre] começou com uma pergunta simples: Que relação existe entre o trabalho, as regras e a automação, ou seja, a invenção de novas tecnologias? Para responder a esta questão, iluminou práticas, máquinas e algoritmos a partir de diferentes perspectivas – da dimensão “concreta” da produção e da dimensão “abstrata” de disciplinas como a matemática e a informática. A preocupação, no entanto, não tem sido repetir a separação dos domínios concreto e abstrato, mas ver a sua coevolução ao longo da história: eventualmente, investigar o trabalho, as regras e a automação, dialeticamente, como abstrações materiais. O capítulo inicial sublinha este aspecto, destacando como os rituais antigos, os instrumentos de contagem e os “algoritmos sociais” contribuíram para a elaboração das ideias matemáticas. Afirmar, como o fez a introdução, que o trabalho é uma atividade lógica não é uma forma de abdicar da mentalidade das máquinas industriais e dos algoritmos empresariais, mas antes reconhecer que a práxis humana exprime a sua própria lógica (uma anti-lógica, poderia se dizer) – um poder de especulação e invenção, antes de a tecnociência o capturar e alienar [4].

A tese de que o trabalho tem de se tornar “mecânico” por si só, antes que a maquinaria o substitua, é um velho princípio fundamental que foi simplesmente esquecido. Remonta, pelo menos, à exposição de Adam Smith em A Riqueza das Nações (1776), que Hegel também comentou já nas suas conferências de Jena (1805-6). A noção de Hegel de “trabalho abstrato” como o trabalho que dá “forma” à maquinaria já estava em dívida para com a economia política britânica antes de Marx contribuir com a sua própria crítica radical ao conceito. Coube a Charles Babbage sistematizar a visão de Adam Smith numa consistente “teoria do trabalho da automação”. Babbage complementou esta teoria com o “princípio do cálculo do trabalho” (conhecido desde então como o “princípio de Babbage”) para indicar que a divisão do trabalho também permite o cálculo exato dos custos do trabalho. Este livro pode ser considerado uma exegese dos dois “princípios de análise do trabalho” de Babbage e da sua influência na história comum da economia política, da computação automatizada e da inteligência das máquinas. Embora possa parecer anacrônico, a teoria da automatização e da extração de mais-valia relativa de Marx partilha postulados comuns com os primeiros projetos de inteligência artificial.

Marx derrubou a perspetiva industrialista – “o olho do mestre” – que era inerente aos princípios de Babbage. Em O Capital, argumentou que as “relações sociais de produção” (a divisão do trabalho no sistema salarial) impulsionam o desenvolvimento dos “meios de produção” (máquinas-ferramentas, motores a vapor, etc.) e não o contrário, como as leituras tecno-deterministas têm vindo a afirmar, centrando a revolução industrial apenas na inovação tecnológica. Destes princípios de análise do trabalho, Marx fez ainda outra coisa: considerou a cooperação do trabalho não só como um princípio para explicar o design das máquinas, mas também para definir a centralidade política daquilo a que chamou o “Gesamtarbeiter“, o “trabalhador geral”. A figura do trabalhador geral era uma forma de reconhecer a dimensão maquínica do trabalho vivo e de confrontar o “vasto autômato” da fábrica industrial com a mesma escala de complexidade. Eventualmente, foi também uma figura necessária para fundamentar, numa política mais sólida, a ideia ambivalente do “intelecto geral” (general intellect) que os socialistas ricardianos, como William Thompson e Thomas Hodgskin, perseguiam.

Das linhas de montagem ao reconhecimento de padrões

Este livro apresentou uma história alargada da divisão do trabalho e das suas métricas como forma de identificar o princípio operativo da IA a longo prazo. Como vimos, na virada do século XIX, quanto mais a divisão do trabalho se estendia a um mundo globalizado, mais problemática se tornava a sua gestão, exigindo novas técnicas de comunicação, controle e “inteligência”. Se, no interior da fábrica a gestão do trabalho podia ainda ser esboçada num simples fluxograma e medida por um relógio, era muito complicado visualizar e quantificar aquilo que Émile Durkheim, já em 1893, definia como “a divisão do trabalho social“[5]. A “inteligência” do patrão da fábrica já não podia vigiar todo o processo de produção num único olhar; agora, só as infraestruturas de comunicação podiam desempenhar esse papel de supervisão e quantificação. Os novos meios de comunicação de massas, como o telégrafo, o telefone, a rádio e as redes de televisão, tornaram possível a comunicação entre países e continentes, mas também abriram novas perspectivas sobre a sociedade e os comportamentos coletivos. James Beniger descreveu corretamente a ascensão das tecnologias da informação como uma “revolução do controle” que se revelou necessária nesse período para governar o boom econômico e o excedente comercial do Norte Global. Após a Segunda Guerra Mundial, o controle desta logística alargada passou a ser preocupação de uma nova disciplina militar que fazia a ponte entre a matemática e a gestão: a pesquisa operacional (Operations Research). No entanto, há que ter em conta que as transformações da classe trabalhadora no interior de cada país e entre países, marcadas por ciclos de conflitos urbanos e lutas descoloniais, foram também um dos fatores que levaram ao aparecimento destas novas tecnologias de controle.

A mudança de escala da composição do trabalho do século XIX para o século XX também afetou a lógica da automatização, ou seja, os paradigmas científicos envolvidos nesta transformação. A divisão industrial do trabalho relativamente simples e as suas linhas de montagem aparentemente retilíneas podem ser facilmente comparadas a um simples algoritmo, um procedimento baseado em regras com uma estrutura “se/então“(if/then) que tem o seu equivalente na forma lógica da dedução. A dedução, não por coincidência, é a forma lógica que, através de Leibniz, Babbage, Shannon e Turing, se inervou na computação eletromecânica e, eventualmente, na IA simbólica. A lógica dedutiva é útil para modelar processos simples, mas não sistemas com uma multiplicidade de agentes autônomos, como a sociedade, o mercado ou o cérebro. Nestes casos, a lógica dedutiva é inadequada porque explodiria qualquer procedimento, máquina ou algoritmo num número exponencial de instruções. A partir de preocupações semelhantes, a cibernética começou a investigar a auto-organização em seres vivos e máquinas para simular a ordem em sistemas de alta complexidade que não podiam ser facilmente organizados de acordo com métodos hierárquicos e centralizados. Esta foi fundamentalmente a razão de ser do conexionismo e das redes neurais artificiais, bem como da investigação inicial sobre redes de comunicação distribuídas, como a Arpanet (a progenitora da Internet).

Ao longo do século XX, muitas outras disciplinas registaram a crescente complexidade das relações sociais. Os conceitos gêmeos de “Gestalt” e “padrão” (“pattern”), por exemplo, utilizados respectivamente por Kurt Lewin e Friedrich Hayek, foram um exemplo da forma como a psicologia e a economia responderam a uma nova composição da sociedade. Lewin introduziu noções holísticas como “campo de forças”(“force field”) e “espaço hodológico” (“hodological space”) para mapear a dinâmica de grupo a diferentes escalas entre o indivíduo e a sociedade de massas[6].

O pensamento francês tem sido particularmente fértil e progressivo nesta direção. Os filósofos Gaston Bachelard e Henri Lefebvre propuseram, por exemplo, o método da “ritmanálise” (“rhythmanalysis”) como estudo dos ritmos sociais no espaço urbano (que Lefebvre descreveu de acordo com as quatro tipologias de arritmia, polirritmia, eurritmia e isorritmia [7]). De forma semelhante, a arqueologia francesa dedicou-se ao estudo de formas alargadas de comportamento social nas civilizações antigas. Por exemplo, o paleoantropólogo André Leroi-Gourhan, juntamente com outros, introduziu a ideia de cadeia operacional (“chaîne opératoire”) para explicar a forma como os humanos pré-históricos produziam utensílios [8]. No culminar desta longa tradição de “diagramatização” dos comportamentos sociais no pensamento francês, Gilles Deleuze escreveu o seu célebre “Pós-escrito sobre a Sociedade de Controle”, no qual afirmava que o poder já não se preocupava com a disciplina dos indivíduos, mas com o controle dos “dividuais”, ou seja, dos fragmentos de um corpo alargado e desconstruído [9].

Os campos de força de Lewin, os ritmos urbanos de Lefebvre e os dividuais de Deleuze podem ser vistos como previsões dos princípios de “governação algorítmica” que se estabeleceram com a sociedade em rede e os seus vastos centros de dados desde o final da década de 1990. O lançamento em 1998 do algoritmo PageRank da Google – um método para organizar e pesquisar o hipertexto caótico da Web – é considerado, por convenção, a primeira elaboração em grande escala de “grandes dados” das redes digitais [10]. Atualmente, estas técnicas de mapeamento de redes tornaram-se onipresentes: O Facebook, por exemplo, utiliza o protocolo Open Graph para quantificar as redes de relações humanas que alimentam a economia da atenção da sua plataforma [11]. O exército dos EUA tem utilizado as suas próprias técnicas controversas de “análise de padrões de vida” para mapear redes sociais em zonas de guerra e identificar alvos de ataques de drones que, como é sabido, mataram civis inocentes [12]. Mais recentemente, as plataformas da gig economy (“Economia do Bico”) e os gigantes da logística, como a Uber, a Deliveroo, a Wolt e a Amazon, começaram a localizar a sua frota de passageiros e condutores através de aplicações de geolocalização [13]. Todas estas técnicas fazem parte do novo domínio da “análise de pessoas” (também conhecida como “física social” ou “psicografia”), que é a aplicação da estatística, da análise de dados e da aprendizagem automática ao problema da força de trabalho na sociedade pós-industrial [14].

A automação da psicometria, ou inteligência geral (general intellect)

A divisão do trabalho, tal como o design das máquinas e dos algoritmos, não é uma forma abstrata em si, mas um meio de medir o trabalho e os comportamentos sociais e de diferenciar as pessoas em função da sua capacidade produtiva. Tal como os princípios de Babbage indicam, qualquer divisão do trabalho implica uma métrica: uma medição da performatividade e da eficiência dos trabalhadores, mas também um juízo sobre as classes de competências, o que implica uma hierarquia social implícita. A métrica do trabalho foi introduzida para avaliar o que é e o que não é produtivo, para manipular uma assimetria social e, ao mesmo tempo, declarar uma equivalência ao sistema monetário. Durante a era moderna, as fábricas, os quartéis e os hospitais têm procurado disciplinar e organizar os corpos e as mentes com métodos semelhantes, tal como Michel Foucault, entre outros, pressentiu.

No final do século XIX, a metrologia do trabalho e dos comportamentos encontrou um aliado num novo campo da estatística: a psicometria. A psicometria tinha como objetivo medir as competências da população na resolução de tarefas básicas, fazendo comparações estatísticas em testes cognitivos em vez de medir o desempenho físico, como no campo anterior da psicofísica [15]. Como parte do legado controverso de Alfred Binet, Charles Spearman e Louis Thurstone, a psicometria pode ser considerada uma das principais genealogias da estatística, que nunca foi uma disciplina neutra, mas sim uma disciplina preocupada com a “medida do homem”, a instituição de normas de comportamento e a repressão de anomalias [16]. A transformação da métrica do trabalho em psicometria do trabalho é uma passagem fundamental tanto para a gestão como para o desenvolvimento tecnológico no século XX. É revelador que, ao conceber o primeiro perceptron de rede neural artificial, Frank Rosenblatt tenha se inspirado não só nas teorias da neuroplasticidade, mas também nas ferramentas de análise multivariável que a psicometria importou para a psicologia norte-americana na década de 1950.

Nesta perspetiva, este livro tenta esclarecer como o projeto de IA surgiu, na realidade, da automação da psicometria do trabalho e dos comportamentos sociais – e não da procura da solução do “enigma” da inteligência. Num resumo conciso da história da IA, pode se dizer que a mecanização do “intelecto geral” (“general intellect”) da era industrial na “inteligência artificial” do século XXI foi possível graças à medição estatística da competência, como o fator de “inteligência geral” de Spearman, e à sua posterior automatização em redes neurais artificiais. Se na era industrial a máquina era considerada uma encarnação da ciência, do conhecimento e do “intelecto geral” (“general intellect”) dos trabalhadores, na era da informação as redes neurais artificiais tornaram-se as primeiras máquinas a codificar a “inteligência geral” em ferramentas estatísticas – no início, especificamente, para automatizar o reconhecimento de padrões como uma das tarefas-chave da “inteligência artificial”. Em suma, a forma atual de IA, a aprendizagem automática, é a automatização das métricas estatísticas que foram originalmente introduzidas para quantificar as capacidades cognitivas, sociais e relacionadas com o trabalho. A aplicação da psicometria através das tecnologias da informação não é um fenômeno exclusivo da aprendizagem automática. O escândalo de dados de 2018 entre o Facebook e a Cambridge Analytica, em que a empresa de consultoria conseguiu recolher os dados pessoais de milhões de pessoas sem o seu consentimento, é um lembrete de como a psicometria em grande escala continua a ser utilizada por empresas e atores estatais numa tentativa de prever e manipular comportamentos coletivos [17].

Dado o seu legado nas ferramentas estatísticas da biometria do século

XIX, também não é surpreendente que as redes neurais artificiais

profundas tenham recentemente se desdobrado em técnicas avançadas de

vigilância, como o reconhecimento facial e a análise de padrões de vida.

Acadêmicos críticos da IA, como Ruha Benjamin e Wendy Chun, entre

outros, expuseram as origens racistas destas técnicas de identificação e

definição de perfis que, tal como a psicometria, quase representam uma

prova técnica do viés social (“social bias”) da IA [18].

Identificaram, com razão, o poder da discriminação no cerne da

aprendizagem automática e a forma como esta se alinha com os aparelhos

de normatividade da era moderna, incluindo as taxonomias questionáveis

da medicina, da psiquiatria e do direito penal [19].

A metrologia

da inteligência iniciada nos finais do século XIX, com a sua agenda

implícita e explícita de segregação social e racial, continua a

funcionar no cerne da IA para disciplinar o trabalho e reproduzir as

hierarquias produtivas do conhecimento. Por conseguinte, a lógica da IA

não é apenas a automação do trabalho, mas o reforço destas hierarquias

sociais de uma forma indireta. Ao declarar implicitamente o que pode ser

automatizado e o que não pode, a IA impôs uma nova métrica da

inteligência em cada fase do seu desenvolvimento. Mas comparar a

inteligência humana e a inteligência das máquinas implica também um

julgamento sobre que comportamento humano ou grupo social é mais

inteligente do que outro, que trabalhadores podem ser substituídos e

quais não podem. Em última análise, a IA não é apenas um instrumento

para automatizar o trabalho, mas também para impor padrões de

inteligência mecânica que propagam, de forma mais ou menos invisível,

hierarquias sociais de conhecimentos e competências. Tal como

acontece com qualquer forma anterior de automatização, a IA não se

limita a substituir trabalhadores, mas desloca-os e reestrutura-os numa

nova ordem social.

A automação da automação

Se observarmos atentamente como os instrumentos estatísticos concebidos para avaliar as competências cognitivas e discriminar a produtividade das pessoas se transformaram em algoritmos, torna-se evidente um aspecto mais profundo da automação. De fato, o estudo da metrologia do trabalho e dos comportamentos revela que a automação emerge, em alguns casos, da transformação dos próprios instrumentos de medição em tecnologias cinéticas. Os instrumentos de quantificação do trabalho e de discriminação social tornaram-se “robôs” por direito próprio. Antes da psicometria, se poderia referir a forma como o relógio utilizado para medir o tempo de trabalho na fábrica foi mais tarde implementado por Babbage para a automatização do trabalho mental na Máquina Diferencial. Os cibernéticos, como Norbert Wiener, continuaram a considerar o relógio como um modelo-chave tanto para o cérebro como para o computador. A este respeito, o historiador da ciência Henning Schmidgen observou como a cronometria dos estímulos nervosos contribuiu para a consolidação da metrologia cerebral e também para o modelo de redes neurais de McCulloch e Pitts [20]. A teoria da automação que este livro ilustrou não aponta, portanto, apenas para a emergência de máquinas a partir da lógica da gestão do trabalho, mas também a partir dos instrumentos e métricas para quantificar a vida humana em geral e torná-la produtiva.

Este livro procurou mostrar que a IA é o culminar da longa evolução da automação do trabalho e da quantificação da sociedade. Os modelos estatísticos da aprendizagem automática não parecem, de fato, ser radicalmente diferentes da concepção das máquinas industriais, mas antes homólogos a elas: são, de fato, constituídos pela mesma inteligência analítica das tarefas e dos comportamentos coletivos, embora com um grau de complexidade mais elevado (isto é, número de parâmetros). Tal como as máquinas industriais, cuja concepção surgiu gradualmente através de tarefas de rotina e de ajustes por tentativa e erro, os algoritmos de aprendizagem automática adaptam o seu modelo interno aos padrões dos dados de treino através de um processo comparável de tentativa e erro. Pode dizer-se que a concepção de uma máquina, bem como a de um modelo de um algoritmo estatístico, seguem uma lógica semelhante: ambos se baseiam na imitação de uma configuração externa de espaço, tempo, relações e operações. Na história da IA, isto era tão verdadeiro para o perceptron de Rosenblatt (que visava registar os movimentos do olhar e as relações espaciais do campo visual) como para qualquer outro algoritmo de aprendizagem de máquinas atual (por exemplo, máquinas de vetores de apoio, redes bayesianas, modelos de transformadores).

Enquanto a máquina industrial incorpora o diagrama da divisão do trabalho de uma forma determinada (pensemos nos componentes e nos “graus de liberdade” limitados de um tear têxtil, de um torno ou de uma escavadora mineira), os algoritmos de aprendizagem automática (especialmente os modelos recentes de IA com um vasto número de parâmetros) podem imitar atividades humanas complexas [21]. Embora com níveis problemáticos de aproximação e enviesamento, um modelo de aprendizagem automática é um artefato adaptativo que pode codificar e reproduzir as mais diversas configurações de tarefas. Por exemplo, um mesmo modelo de aprendizagem automática pode imitar tanto o movimento de braços robóticos em linhas de montagem como as operações do condutor de um automóvel autônomo; o mesmo modelo pode também traduzir entre línguas tanto como descrever imagens com palavras coloquiais.

O surgimento de grandes modelos de base nos últimos anos (por exemplo, BERT, GPT, CLIP, Codex) demonstra como um único algoritmo de aprendizagem profunda pode ser treinado num vasto conjunto de dados integrado (incluindo texto, imagens, fala, dados estruturados e sinais 3D) e utilizado para automatizar uma vasta gama das chamadas tarefas a jusante (resposta a perguntas, análise de sentimentos, extração de informações, geração de texto, legendagem de imagens, geração de imagens, transferência de estilos, reconhecimento de objetos, seguimento de instruções, etc.) [22]. Pela forma como foram construídos com base em grandes repositórios de patrimônio cultural, conhecimento coletivo e dados sociais, os grandes modelos de base são a aproximação mais próxima da mecanização do “intelecto geral” que foi prevista na era industrial. Um aspecto importante da aprendizagem automática que os modelos de base demonstram é que a automação de tarefas individuais, a codificação do patrimônio cultural e a análise de comportamentos sociais não têm qualquer distinção técnica: podem ser realizadas por um único e mesmo processo de modelação estatística.

Em conclusão, a aprendizagem automática pode ser vista como o projeto de automatizar o próprio processo de concepção de máquinas e de criação de modelos – ou seja, a automação da teoria laboral da própria automação. Neste sentido, a aprendizagem automática e, especificamente, os modelos de grandes fundações representam uma nova definição de Máquina Universal, pois a sua capacidade não se limita a executar tarefas computacionais, mas a imitar o trabalho e os comportamentos coletivos em geral. O avanço que a aprendizagem automática passou a representar não é, portanto, apenas a “automação da estatística”, como a aprendizagem automática é por vezes descrita, mas a automação da automação, trazendo este processo para a escala do conhecimento coletivo e do patrimônio cultural [23]. Além disso, a aprendizagem automática pode ser considerada como a prova técnica da integração progressiva da automação do trabalho e da governação social. Emergindo da imitação da divisão do trabalho e da psicometria, os modelos de aprendizagem automática evoluíram gradualmente para um paradigma integrado de governança que a análise de dados empresariais e os seus vastos centros de dados bem exemplificam.

Desfazendo o Algoritmo Mestre

Tendo em conta a dimensão crescente dos conjuntos de dados, os custos de formação dos grandes modelos e o monopólio da infraestrutura de computação em nuvem que é necessário para que algumas empresas como a Amazon, a Google e a Microsoft (e as suas congéneres asiáticas Alibaba e Tencent) hospedarem esses modelos, tornou-se evidente para todos que a soberania da IA continua a ser um assunto difícil à escala geopolítica. Além disso, a confluência de diferentes aparelhos de governança (ciência climática, logística global e até cuidados de saúde) para o mesmo hardware (computação em nuvem) e software (aprendizagem de máquina) assinala uma tendência ainda mais forte para a monopolização. Para além da notória questão da acumulação de poder, a ascensão dos monopólios de dados aponta para um fenômeno de convergência técnica que é fundamental para este livro: os meios de trabalho tornaram-se os mesmos meios de medição e, do mesmo modo, os meios de gestão e logística tornaram-se os mesmos meios de planejamento econômico.

Isto também se tornou evidente durante a pandemia de Covid-19, quando foi criada uma grande infraestrutura para acompanhar, medir e prever os comportamentos sociais [24]. Esta infraestrutura, sem precedentes na história dos cuidados de saúde e da biopolítica, não foi, no entanto, criada ex nihilo, mas construída a partir de plataformas digitais existentes que orquestram a maior parte das nossas relações sociais. Sobretudo durante os períodos de confinamento, o mesmo meio digital foi utilizado para trabalhar, fazer compras, comunicar com a família e os amigos e, eventualmente, para os cuidados de saúde. As métricas digitais do corpo social, como a geolocalização e outros metadados, foram fundamentais para os modelos preditivos do contágio global, mas elas são usadas há muito tempo para acompanhar o trabalho, a logística, o comércio e a educação. Filósofos como Giorgio Agamben afirmaram que esta infraestrutura prolongou o estado de emergência da pandemia, quando, na verdade, a sua utilização nos cuidados de saúde e na biopolítica dá continuidade a décadas de monitorização da produtividade econômica do corpo social, que passou despercebida a muitos [25].

A convergência técnica das infraestruturas de dados revela também que a automação contemporânea não se limita à automação do trabalhador individual, como na imagem estereotipada do robô humanoide, mas à automação dos patrões e gestores da fábrica, como acontece nas plataformas da gig economy. Dos gigantes de logística (Amazon, Alibaba, DHL, UPS, etc.) e da mobilidade (Uber, Share Now, Foodora, Deliveroo) às redes sociais (Facebook, TikTok, Twitter), o capitalismo de plataforma é uma forma de automação que, na realidade, não substitui os trabalhadores, mas multiplica-os e governa-os de novo. Desta vez, não se trata tanto da automação do trabalho, mas sim da automação da gestão. Sob esta nova forma de gestão algorítmica, todos nós passamos a ser trabalhadores individuais de um vasto autômato composto por utilizadores globais, “turkers“, prestadores de cuidados, condutores e cavaleiros de muitos tipos. O debate sobre o receio de que a IA venha a substituir totalmente os empregos é errôneo: na chamada economia das plataformas, os algoritmos substituem a gestão e multiplicam os empregos precários. Embora as receitas da gig economy continuem a ser pequenas em relação aos setores locais tradicionais, ao utilizarem a mesma infraestrutura a nível mundial, estas plataformas estabeleceram posições de monopólio. O poder do novo “mestre” não está na automatização de tarefas individuais, mas na gestão da divisão social do trabalho. Contra a previsão de Alan Turing, é o mestre, e não o trabalhador, que o robô veio substituir em primeiro lugar [26].

Nos perguntamos qual seria a possibilidade de intervenção política num espaço tão tecnologicamente integrado e se o apelo ao “redesign da IA” que as iniciativas populares e institucionais defendem é razoável ou praticável. Este apelo deveria começar por responder a uma questão mais premente: Como é que é possível “redesenhar” os monopólios de dados e conhecimento em grande escala [27]? À medida que grandes empresas como a Amazon, a Walmart e a Google conquistaram um acesso único às necessidades e aos problemas de todo o corpo social, um movimento crescente pede não só que estas infraestruturas se tornem mais transparentes e responsáveis, mas também que sejam coletivizadas como serviços públicos (como sugeriu Fredric Jameson, entre outros), ou que sejam substituídas por alternativas públicas (como defendeu Nick Srnicek [28]). Mas qual seria uma forma diferente de projetar essas alternativas?

Tal como a teoria da automação deste livro sugere, qualquer aparelho tecnológico e institucional, incluindo a IA, é uma cristalização de um processo social produtivo. Os problemas surgem porque essa cristalização “ossifica” e

reitera estruturas, hierarquias e desigualdades do passado. Para

criticar e desconstruir artefatos complexos como os monopólios de IA,

devemos começar por fazer o trabalho meticuloso do desconexão

(“deconnectionism”) , desfazendo – passo a passo, arquivo a

arquivo, conjunto de dados a conjunto de dados, metadado a metadado,

correlação a correlação, padrão a padrão – o tecido social e econômico

que os constitui na origem. Este trabalho já está sendo

desenvolvido por uma nova geração de acadêmicos que estão a dissecar a

cadeia de produção global de IA, especialmente os que utilizam métodos

de “pesquisa-ação”. Destacam-se, entre muitos outros, a plataforma Turkopticon

de Lilly Irani, utilizada para “interromper a invisibilidade do

trabalhador” na plataforma de trabalho temporário Amazon Mechanical

Turk; a investigação de Adam Harvey

sobre conjuntos de dados de treino para reconhecimento facial, que expôs

as violações maciças da privacidade das empresas de IA e da

investigação acadêmica; e o trabalho do coletivo Politically Mathematics

da Índia, que analisou o impacto econômico dos modelos preditivos da

Covid-19 nas populações mais pobres e recuperou a matemática como um

espaço de luta política (ver o seu manifesto citado no início deste

texto).

A teoria laboral da automação é um princípio analítico

para estudar o novo “olho do mestre” que os monopólios de IA encarnam.

No entanto, precisamente devido à sua ênfase no processo de trabalho e

nas relações sociais que constituem os sistemas técnicos, é também um

princípio sintético e “sociogênico” (para utilizar o termo programático

de Frantz Fanon e Sylvia Wynter [29]). O que está no cerne da teoria

laboral da automação é, em última análise, uma prática de autonomia

social. As tecnologias só podem ser julgadas, contestadas,

reapropriadas e reinventadas se se inserirem na matriz das relações

sociais que originalmente as constituíram. As tecnologias

alternativas devem situar-se nestas relações sociais, de uma forma não

muito diferente do que os movimentos cooperativos fizeram nos séculos

passados. Mas construir algoritmos alternativos não significa torná-los

mais éticos. Por exemplo, a proposta de codificação de regras éticas na

IA e nos robôs parece altamente insuficiente e incompleta, porque não

aborda diretamente a função política geral da automação no seu cerne

[30].

O que é necessário não é nem o tecnosolucionismo nem o tecnopauperismo, mas sim uma cultura de invenção, concepção e planejamento que se preocupe com as comunidades e o coletivo, sem nunca ceder totalmente a agência e a inteligência à automação. O primeiro passo da tecnopolítica não é tecnológico, mas político. Trata-se de emancipar e descolonizar, quando não de abolir na totalidade, a organização do trabalho e das relações sociais em que se baseiam os sistemas técnicos complexos, os robôs industriais e os algoritmos sociais – especificamente o sistema salarial, os direitos de propriedade e as políticas de identidade que lhes estão subjacentes. As novas tecnologias do trabalho e da sociedade só podem se basear nesta transformação política. É evidente que este processo se desenrola através do desenvolvimento de conhecimentos não só técnicos mas também políticos. Um dos efeitos problemáticos da IA na sociedade é a sua influência epistêmica – a forma como transforma a inteligência em inteligência de máquina e promove implicitamente o conhecimento como conhecimento processual. O projeto de uma epistemologia política que transcenda a IA terá, no entanto, de transmutar as formas históricas do pensamento abstrato (matemático, mecânico, algorítmico e estatístico) e integrá-las como parte da caixa de ferramentas do próprio pensamento crítico. Ao confrontar a epistemologia da IA e o seu regime de extrativismo do conhecimento, é necessário aprender uma mentalidade técnica diferente, uma “contra-inteligência” coletiva.

Notas:

[1]: “Disruption: A Manifesto,” Logic Magazine, no. 1, março de 2017.

[2]: Politically Mathematics collective, “Politically Mathematics Manifesto,” 2019

[3]: Karl Marx, Capital, Livro 1: O processo de produção do capital, p.330. Trad. Rubens Enderle. Boitempo, 2013

[4]: Veja

o debate sobre o processo trabalhista em: Harry Braverman, Labor and

Monopoly Capital: The Degradation of Work in the Twentieth Century

(Monthly Review Press, 1974); David Noble, Forces of Production: A

Social History of Industrial Automation (Oxford University Press, 1984).

[5]: Émile Durkheim, “Da Divisão do Trabalho Social” (1893), publicado no Brasil com esse título, por entre outras, a WMF Martins Fontes, em tradução de Eduardo Brandão.

[6]:

Kurt Lewin, “Die Sozialisierung des Taylorsystems: Eine grundsätzliche

Untersuchung zur Arbeits- und Berufspsychologie,” Schriftenreihe

Praktischer Sozialismus, vol. 4 (1920) – sem tradução para o português.

Também ver Simon Schaupp, “Taylorismus oder Kybernetik? Eine kurze

ideengeschichte der algorithmischen arbeitssteuerung,” WSI-Mitteilungen

73, no. 3, (2020).

[7]: Gaston Bachelard, “La dialectique de la

durée” (Boivin & Cie, 1936), traduzido no Brasil para “A Dialética

da Duração”, publicado pela Editora Ática em 1993.

Henri Lefebvre, “Éléments de rythmanalyse” (Éditions Syllepse, 1992),

último livro do autor, publicado no Brasil como “Elementos de

Ritmanálise e outros Ensaios” pela Editora Consequência em 2021.

[8]:

Frederic Sellet, “Chaîne Opératoire: The Concept and Its Applications,”

Lithic Technology 18, no. 1–2 (1993). Sem tradução no Brasil

[9]: Gilles Deleuze, “Postscript on the Society of Control,” October, no. 59 (1992). Publicado no Brasil em DELEUZE, Gilles. Conversações: 1972-1990.

Rio de Janeiro: Ed. 34,1992. Ver também David Savat, “Deleuze’s

Objectile: From Discipline to Modulation,” in Deleuze and New

Technology, ed. Mark Poster and David Savat (Edinburgh University Press,

2009).

[10]: Matthew L. Jones, “Querying the Archive: Data Mining

from Apriori to PageRank,” in Science in the Archives, ed. Lorraine

Daston (University of Chicago Press, 2017); Matteo Pasquinelli,

“Google’s PageRank Algorithm: A Diagram of Cognitive Capitalism and the

Rentier of the Common Intellect,” in Deep Search, ed. Konrad Becker and

Felix Stalder (Transaction Publishers, 2009).

[11]: Irina Kaldrack

and Theo Röhle, “Divide and Share: Taxonomies, Orders, and Masses in

Facebook’s Open Graph,” Computational Culture, no. 4 (November 2014);

Tiziana Terranova, “Securing the Social: Foucault and Social Networks,”

in Foucault and the History of Our Present, ed. S. Fuggle, Y. Lanci, and

M. Tazzioli (Palgrave Macmillan, 2015).

[12]: Grégoire Chamayou,

“Pattern-of-Life Analysis,” chap. 5 in A Theory of the Drone (New Press,

2014). Publicado no Brasil como “Teoria do Drone”, pela Cosac & Naify em 2015. Veja também Matteo Pasquinelli, “Metadata Society,”

keyword entry in Posthuman Glossary, ed. Rosi Braidotti and Maria

Hlavajova (Bloomsbury, 2018), e “Arcana Mathematica Imperii: The

Evolution of Western Computational Norms,” in Former West, ed. Maria

Hlavajova and Simon Sheikh (MIT Press, 2017).

[13]: Andrea Brighenti

and Andrea Pavoni, “On Urban Trajectology: Algorithmic Mobilities and

Atmocultural Navigation,” Distinktion: Journal of Social Theory 24, no. 1

(2001).

[14]: M. Giermindl et al., “The Dark Sides of People

Analytics: Reviewing the Perils for Organisations and Employees,”

European Journal of Information Systems 33, no. 3 (2022). Veja também

Alex Pentland, “Social Physics: How Social Networks Can Make Us Smarter”

(Penguin, 2015).

[15]: A palavra “estatística” significava

originalmente o conhecimento que o Estado possuía sobre seus próprios

assuntos e territórios: um conhecimento que tinha de ser mantido em

segredo. Em: Michel Foucault, Security, Territory, Population

(Segurança, Território, População): Lectures at the Collège de France

1977-1978, trans. Graham Burchell (Palgrave Macmillan, 2009).

[16]:

Sobre a influência da metrologia cerebral na história da IA, ver Simon

Schaffer: “Os julgamentos de que as máquinas são inteligentes envolveram

técnicas para medir os resultados do cérebro. Essas técnicas mostram

como o comportamento discricionário está ligado ao status daqueles que

dependem da inteligência para sua legitimidade social.” Schaffer, “OK

Computer”, em Ansichten der Wissenschaftsgeschichte, ed., Michael Hagner

(Fischer, 2001) Michael Hagner (Fischer, 2001). Sobre a metrologia

inicial do sistema nervoso, veja Henning Schmidgen, The Helmholtz

Curves: Tracing Lost Times (Fordham University Press, 2014).

[17]: Luke Stark, “Algorithmic Psychometrics and the Scalable Subject,” Social Studies of Science 48, no. 2 (2018).

[18]:

Ruha Benjamin, Race after Technology: Abolitionist Tools for the New

Jim Code (Polity, 2019); Wendy Chun, Discriminating Data: Correlation,

Neighborhoods, and the New Politics of Recognition (MIT Press, 2021).

Tarcízio Silva fez uma boa análise deste livro em seu blog.

[19]:

Sobre a imbricação de colonialismo, racismo e tecnologias digitais,

veja Jonathan Beller, The World Computer: Derivative Conditions of

Racial Capitalism (Duke University Press, 2021); Seb Franklin, The

Digitally Disposed: Racial Capitalism and the Informatics of Value

(University of Minnesota Press, 2021). No Brasil, ver “Racismo Algorítmico: Inteligência Artificial e Discriminação nas Redes Digitais”, de Tarcízio SIlva, lançado pelas Edições Sesc em 2022;“Colonialismo de dados: como opera a trincheira algorítmica na guerra neoliberal“”, org. de Sérgio Amadeu, Joyce Souza e Rodolfo Avelino lançada em 2021 pela Autonomia Literária; e “Colonialismo Digital: Por uma crítica hacker-fanoniana”, de Deivison Faustino e Walter Lippold, publicado pela Boitempo em 2023.

[20]:

Henning Schmidgen, “Cybernetic Times: Norbert Wiener, John Stroud, and

the ‘Brain Clock’ Hypothesis”, History of the Human Sciences 33, no. 1

(2020). Sobre a cibernética e a “medição da racionalidade”, veja Orit

Halpern, “Beautiful Data: A History of Vision and Reason since 1945”

(Duke University Press, 2015), 173.

[21]: Em mecânica, os graus de

liberdade (DOF) de um sistema, como uma máquina, um robô ou um veículo,

são o número de parâmetros independentes que definem sua configuração ou

estado. Normalmente, diz-se que as bicicletas têm dois graus de

liberdade. Um braço robótico pode ter muitos. Um modelo grande de

aprendizado de máquina, como o GPT, pode ter mais de um trilhão.

[22]: Rishi Bommasani et al., On the Opportunities and Risks of Foundation Models, Center for Research on Foundation Models at the Stanford Institute for Human-Centered Artificial Intelligence, 2021

[23]:

Para uma leitura diferente sobre a automação da automação, ver Pedro

Domingos, The Master Algorithm: How the Quest for the Ultimate Learning

Machine Will Remake Our World (Basic Books, 2015); Luciana Parisi,

“Critical Computation: Digital Automata and General Artificial

Thinking,” Theory, Culture, and Society 36, no. 2 (March 2019).

[24]:

“Breaking Models: Data Governance and New Metrics of Knowledge in the

Time of the Pandemic,” workshop, Max Planck Institute for the History of

Science, Berlin, and KIM research group, University of Arts and Design,

Karlsruhe, September 24, 2021.

[25]: Giorgio Agamben, Where Are We

Now? The Epidemic as Politics, trans. V. Dani (Rowman & Littlefield,

2021). Publicado no Brasil como “Em que ponto estamos?”, pela n-1 edições em 2021.

[26]:

Min Kyung Lee et al., “Working with Machines: The Impact of Algorithmic

and Data-Driven Management on Human Workers,” in Proceedings of the

33rd Annual ACM Conference on Human Factors in Computing Systems,

Association for Computing Machinery, New York, 2015; Sarah O’Connor,

“When Your Boss Is an Algorithm,” Financial Times, September 8, 2016.

See also Alex Wood, “Algorithmic Management Consequences for Work

Organisation and Working Conditions,” no. 2021/07, European Commission

JRC Technical Report, Working Papers Series on Labour, Education, and

Technology, 2021.

[27]: Redesigning AI, ed. Daron Acemoglu (MIT Press), 2021.

[28]:

Leigh Phillips and Michal Rozworski, The People’s Republic of Walmart:

How the World’s Biggest Corporations Are Laying the Foundation for

Socialism (Verso, 2019); Frederic Jameson, Archaeologies of the Future:

The Desire Called Utopia and Other Science Fictions (Verso, 2005),

153n22; Nick Srnicek, Platform Capitalism (Polity Press, 2017), 128.

[29]:

Sylvia Wynter, “Towards the Sociogenic Principle: Fanon, Identity, the

Puzzle of Conscious Experience, and What It Is Like to Be ‘Black,’” in

National Identities and Sociopolitical Changes in Latin America, ed.

Antonio Gomez-Moriana, Mercedes Duran-Cogan (Routledge, 2001). Veja

também Luciana Parisi, “Interactive Computation and Artificial

Epistemologies,” Theory, Culture, and Society 38, no. 7–8 (October

2021).

[30]: Frank Pasquale, New Laws of Robotics: Defending Human

Expertise in the Age of AI (Harvard University Press, 2020); Dan

McQuillan, “People’s Councils for Ethical Machine Learning,” Social

Media+ Society 4, no. 2 (2018).

Fonte: https://outraspalavras.net/tecnologiaemdisputa/por-uma-historia-social-da-ia/

Nenhum comentário:

Postar um comentário