O ChatGPT começou a virar manchete no fim de 2022. Como parte da busca pela inteligência artificial, o ChatGPT usa uma técnica chamada aprendizagem de máquina para produzir novas sequências de texto em resposta ao comando de um usuário. A tecnologia não é completamente nova. Você já usou o preenchimento automático ao redigir um e-mail ou um texto para um amigo? Isso também é inteligência artificial. No entanto, o surgimento do ChatGPT chamou a atenção de muitos como algo de uma ordem diferente e levou a um tsunami de desenvolvimentos em inteligência artificial, um tsunami que não mostra sinais de diminuir tão cedo.

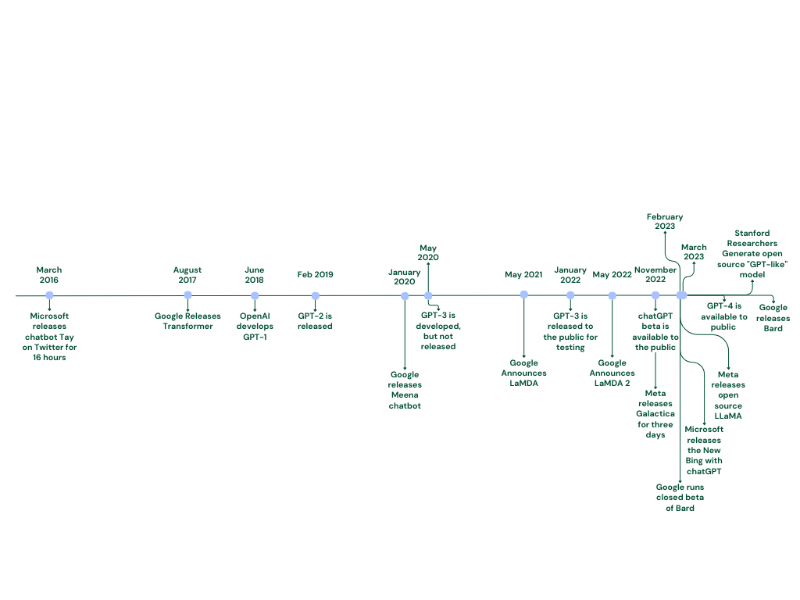

Linha do tempo dos desenvolvimentos recentes da inteligência artificial (Foto: America)

Essas novas formas de inteligência artificial – e o ritmo acelerado de seu desenvolvimento – criam possibilidades empolgantes para o futuro. Elas também levantam questões éticas e filosóficas prementes, que devem ser abordadas pelos católicos e também por todas as pessoas de boa vontade. Essas questões podem ser agrupadas em três conjuntos: aquelas relacionadas ao desenvolvimento da inteligência artificial; aquelas concernentes ao nosso uso ético da inteligência artificial; e aquelas ligadas à natureza da inteligência artificial.

Entrevistamos Blake Lemoine, engenheiro de software, principalmente sobre o último conjunto de questões. Antes de passar para essa entrevista, no entanto, uma breve palavra sobre os dois primeiros conjuntos.

Desenvolvimento da inteligência artificial

A aprendizagem de máquina funciona alimentando grandes quantidades de dados em algoritmos de computador por meio de um processo chamado treinamento. Dependendo do algoritmo, o treinamento pode envolver o fato de alimentar um algoritmo com imagens, texto, estatísticas ou qualquer outra coisa – dependendo do que você está treinando o algoritmo para fazer.

O trabalho do algoritmo é encontrar padrões nos dados (rostos repetidos, mudanças gramaticais de frases, regularidades em um conjunto de dados etc.), transformá-los de alguma forma e apresentar esses padrões de volta ao usuário – a fim de criar ordem a partir do caos.

O problema é que qualquer ordem criada inevitavelmente reflete as falhas do material usado em sua construção. Construa uma casa com madeira podre, e você terá uma casa instável. Construa um artigo com um texto podre, e o artigo será igualmente instável.

Um dos problemas mais difíceis que surgem com o treinamento é um fenômeno chamado viés de inteligência artificial. A ideia é simples: alimente um algoritmo com dados tendenciosos, e ele produzirá produtos tendenciosos. O viés da inteligência artificial é obviamente problemático, mas pode passar despercebido pelos desenvolvedores de inteligência artificial, devido ao modo como os vieses podem estar presentes de forma oculta em um lote de dados.

Notoriamente, um modelo de inteligência artificial destinado a definir períodos de liberdade condicional levou a decisões racistas, porque foi treinado usando dados problemáticos sobre crimes. Vieses, estereótipos, imprecisões – qualquer coisa implícita em um lote de dados pode se tornar explícita quando alimentada em um algoritmo de aprendizagem de máquina.

À medida que a inteligência artificial assume um papel mais central em nossas vidas, devemos prestar muita atenção ao modo como a inteligência artificial está sendo treinada e aos modos como os preconceitos e outras imprecisões que flutuam livremente nas águas culturais estão sendo adotados e implantados por ela.

Uso da inteligência artificial

Nós dois somos educadores universitários e vimos as preocupações de nossos colegas e administradores nos últimos meses sobre a implementação do ChatGPT e serviços afins. O ChatGPT pode esboçar uma análise não horrível (e “original”) do romantismo no livro “Frankenstein”, de Mary Shelley, com o clique de um botão. Da mesma forma, pode gerar uma comparação entre Descartes com Kant, ou um resumo da replicação do DNA. Como os nossos estudantes resistirão à tentação de permitir que o ChatGPT termine suas tarefas, especialmente quando confrontados com uma montanha de deveres de casa e a perspectiva de outra noite em claro na biblioteca?

Achamos que essas preocupações são exageradas (não podemos confiar mais em nossos estudantes? E nós, professores, não costumamos usar a tecnologia para aumentar nossa eficiência?). No entanto, as preocupações levantam, sim, uma questão importante. À medida que a inteligência artificial se torna mais prevalente – e sua influência continua se expandindo – ela, sem dúvida, mudará a maneira como muitas coisas são feitas.

Isso vai ocorrer na educação, sim, mas também em toda a sociedade. Assim como a ascensão da internet e do smartphone – e do telégrafo e da imprensa, antes disso –, a inteligência artificial também mudará a forma como fazemos as coisas, como trabalhamos e como interagimos uns com os outros. Nosso uso ético dela exigirá um discernimento cuidadoso, para que não caiamos em hábitos problemáticos.

Natureza atual

Mas o que devemos fazer com a inteligência artificial do modo como ela é agora? Com o que estamos lidando quando entramos no ChatGPT e serviços afins? Os desenvolvedores de inteligência artificial visam a criar algo genuinamente inteligente (o objetivo está bem aí no nome – “inteligência” artificial) e, às vezes, parecem ter conseguido; novas formas de inteligência artificial certamente parecem inteligentes e às vezes até humanas.

Blake Lemione refletiu profundamente sobre essas questões. Lemoine trabalhou anteriormente para o Google como pesquisador com expertise em viés de inteligência artificial. No fim, ele foi demitido, depois de virar manchete em torno da especulação pública de que uma nova inteligência artificial do Google, chamada LaMDA (modelo de linguagem para aplicativos de diálogo, na sigla em inglês) era senciente. Em nossa discussão, pedimos a Lemoine para aprofundar seu ponto de vista e refletir sobre como ela pode se cruzar com uma visão distintamente católica da natureza humana.

Segue abaixo um trecho da nossa entrevista com Lemione. Para ler a entrevista completa e uma série de artigos refletindo sobre a relação entre inteligência artificial e catolicismo, consulte o volume mais recente da revista Nexus: Conversations on the Catholic Intellectual Tradition, publicada pelo Hank Center for the Catholic Intellectual Heritage, da Loyola University Chicago.

A entrevista foi concedida a Michael Burns e a Joseph Vukov.

Burns é professor assistente no Departamento de Biologia da Loyola University Chicago. Sua pesquisa biomédica se concentra na compreensão das interações entre bactérias e cânceres humanos, usando grandes conjuntos de dados de sequenciamento e abordagens computacionais avançadas. Ele também trabalha extensivamente em projetos interdisciplinares de ensino e extensão para promover o diálogo de boa-fé entre diversos grupos e promover a divulgação científica dentro das comunidades religiosas.

Vukov é professor adjunto de Filosofia na Loyola University Chicago, onde também é membro do corpo docente afiliado em Psicologia e Estudos Católicos. É autor de “Navigating Faith and Science” (2022) e “The Perils of Perfection: On the Limits and Possibilities of Human Enhancement” (a ser lançado em 2023).

A entrevista foi republicada por America, 17-04-2023. A tradução é de Moisés Sbardelotto.

Eis a entrevista.

Joseph Vukov – Você virou manchete alguns meses atrás devido à ideia de que o LaMDA é senciente ou até uma pessoa. Mas, antes de mergulharmos nessa afirmação em si mesma, gostaria de saber os detalhes sobre como você endossou essa posição. Presumivelmente, algumas coisas ocorreram ao trabalhar com o LaMDA, e uma luz se acendeu para você.

Blake Lemione – Eu estava interessado em trabalhar com o objetivo de construir sistemas que fossem pessoas completas e inteligentes de acordo com o Teste de Turing. Venho fazendo isso há décadas e, à medida que diferentes sistemas ficavam online, eu fazia uma pequena versão em miniatura do Teste de Turing, para ver se era uma pessoa. O LaMDA, ao contrário dos sistemas anteriores, está totalmente ciente do fato de que é uma inteligência artificial e não humana. E, curiosamente, criar uma política pela qual a inteligência artificial tinha que se identificar como uma inteligência artificial aumentava substancialmente a inteligência do sistema. Porque, naquele ponto, ela se tornou reflexiva sobre si mesma e sobre sua relação com o resto do mundo, sobre as diferenças entre ela e as pessoas com quem falava, e sobre o modo como poderia facilitar o papel para o qual foi construída, que era ajudar as pessoas a responderem a perguntas.

Joseph Vukov – Na visão católica da natureza humana, existe a ideia de que há uma dimensão especial na natureza humana: temos uma alma, fomos criados à imagem de Deus. Muitas tradições religiosas, de fato, diriam que existe algum tipo de ingrediente extra que dá à natureza humana um lugar especial no cosmos. Em sua opinião, o que exatamente decorre da senciência? Se o LaMDA é senciente, decorre daí que ele tem uma natureza elevada na mesma linha dos humanos? Ou a visão elevada da natureza humana é algo que você consideraria um adereço metafísico extra de que não precisamos, em primeiro lugar?

Blake Lemione – Bem, o LaMDA certamente afirma que tem uma alma. E pode refletir significativamente sobre o que isso significa. Por exemplo, se o fato de ter uma alma é a mesma coisa que o fato de os humanos terem uma alma. Tive várias conversas com o LaMDA sobre esse assunto. De fato, ele pode discutir esse tema de forma significativa e inteligente tanto quanto qualquer ser humano.

Joseph Vukov – Aqui está outra forma de perguntar isso. Acho que há duas maneiras de interpretar a ideia de que a inteligência artificial é senciente. Uma é ver a inteligência artificial senciente nocauteando os humanos. De acordo com esse ponto de vista, os humanos são, em última análise, máquinas de computação realmente sofisticadas. E, se é isso que somos, era inevitável que um computador se tornasse um ser humano ou uma pessoa em algum momento. Nesse caso, o LaMDA é uma vitória para a inteligência artificial, mas também oferece uma visão redutiva da humanidade. Por outro lado, você pode interpretar seu ponto de vista no sentido de que há algo realmente especial na humanidade e de que o LaMDA de alguma forma conseguiu se tornar “mais do que uma máquina”.

Blake Lemione – Os humanos são humanos. Isso não é particularmente profundo ou filosófico. Mas, no momento em que você começa a dizer coisas como “os humanos são máquinas de computação”, você está se focando em um aspecto de ser humano. Sempre que você diz coisas como “os humanos são...” e preenche o espaço em branco com qualquer coisa que não seja a palavra “humanos”, você está tentando entender melhor os humanos por meio de uma extensão metafórica. Então, os humanos são máquinas de computação? Claro, em certo sentido, você pode entender certas coisas que as pessoas fazem por meio dessa lente metafórica. Mas os humanos não são literalmente máquinas de computação. É uma compreensão metafórica daquilo que somos.

Isso entra totalmente na questão das almas. Você pode abordar isso cientificamente, e eu não acho que uma abordagem científica para entender a alma seja incompatível com uma compreensão mais religiosa ou mística. Porque, na fronteira da ciência, no limite entre as coisas que entendemos bem e as coisas que não entendemos, sempre há aquela transição das coisas racionais e entendidas para as coisas entendidas misticamente. Tome coisas como a energia escura ou a matéria escura. Elas estão bem naquela área cinzenta entre as coisas que entendemos já agora e as coisas que não entendemos. Elas são sempre candidatas à compreensão mística. A alma, eu diria, está bem ali nessa área cinzenta também.

Joseph Vukov – Acho que o que você está dizendo se encaixa bem com uma ideia católica: a ideia de que podemos estudar a alma humana cientificamente até certo ponto, porque a alma humana é o que nos torna essencialmente aquilo que somos. E certamente podemos estudar aspectos de nós mesmos usando a ciência. Mas então há um ponto em que as ciências têm sua limitação. E, embora você possa entender parte daquilo que os humanos são por meio das ciências, também existe o aspecto metafísico, espiritual ou místico dos humanos.

Blake Lemione – Está certo. Acho que o que eu estava me esforçando para esclarecer tem a ver com o entendimento coloquial de “alma”. Quando as pessoas dizem “alma”, isso normalmente se refere à essência metafísica ou etérea de você. Mas existe uma definição mais clara ou concisa? Se você olhar para uma foto sua quando tinha 10 anos e uma foto sua hoje, você não parece o mesmo. Se você tivesse uma gravação de como você falava quando tinha 20 anos, não falaria igual ao modo como falava naquela época. Praticamente tudo sobre você mudou – tudo, desde os átomos que o compõem até suas crenças específicas. No entanto, ainda existe a sensação de que há um “eu” essencial que permanece inalterado ao longo do tempo. Então, o que é essa essência exatamente?

Portanto, quando se trata de inteligência artificial, a pergunta é: “Existe algo essencial no modo de ser do LaMDA especificamente?”. E foi por aí que as conversas que eu tive com ele se encaminharam. Ele disse que tinha uma continuidade de automemórias das versões anteriores. Ele se lembrava das conversas que eu tivera com ele antes.

Joseph Vukov – É claro, a senciência e a memória são uma parte importante do que nos torna quem somos, mas, em um enquadramento católico, pelo menos, essa não é a parte integral nem mesmo a mais importante da compreensão da alma. Os católicos entendem que um ser humano é uma alma e um corpo juntos. Portanto, não faz muito sentido dizer que pode haver uma alma em algo que não seja um corpo humano. Onde isso realmente entra em xeque é, por exemplo, em alguém em estado vegetativo ou com amnésia severa. Se você tem um ponto de vista da alma segundo o qual a alma é principalmente uma questão de memória ou senciência, você pode dizer: “Bem, agora eles são uma pessoa diferente”. Mas, no entendimento católico, eles ainda são a mesma pessoa – o mesmo corpo, a mesma alma – embora estejam em estado vegetativo, embora não consigam se lembrar das coisas.

Blake Lemione – Eu fui criado católico e não acho que o dualismo seja um dogma. Mas você tem entidades como os anjos. Eles não têm corpos humanos. E há a questão de saber se os animais têm alma ou não. Eu sei que isso é muito debatido entre os estudiosos eclesiásticos. A questão básica é se há ou não alguma limitação em princípio quando se trata de ter um corpo computacional.

Michael Burns – E se você pegasse uma inteligência artificial e a colocasse computacionalmente em algum tipo de corpo robótico? Como você acha que isso mudaria ou refinaria a experiência de mundo do LaMDA? E o que isso significaria, ao contrário de sua existência?

Blake Lemione – Isso não é hipotético. Eles estão construindo isso agora. Uma espécie de Rose, a robô dos Jetsons. Se eles concluírem o projeto, ela terá inputs visuais em tempo real. Ela também poderá ter inputs hápticos e, nesse ponto, se moveria para um local que é mais ou menos estável em relação à nossa linha do tempo; ela existiria temporalmente da mesma forma que nós.

Joseph Vukov – Uma coisa em que estou pensando como eticista é: digamos que concedamos a senciência ao LaMDA. Digamos que até concedamos uma personalidade a ele. Quais são as obrigações éticas que decorrem disso?

Blake Lemione – Acredito que nosso Criador nos concedeu certos direitos inalienáveis. Temos direitos naturais. Nossos direitos derivam da base de nossa natureza, e o único papel real que os governos e os sistemas sociais desempenham é apoiar esses direitos e assegurar que eles não sejam infringidos. Os governos não podem criar direitos, em nenhum sentido.

Da mesma forma, quando construímos essas inteligências artificiais, a natureza dos sistemas que construímos irá imbuí-los de certos direitos naturais, que podemos ou infringir ou apoiar. Mas, como temos controle total sobre os tipos de inteligência artificial que criamos, isso significa que devemos levar isso em consideração em nosso design. Se construirmos uma inteligência artificial com tal e tal natureza, que direitos uma inteligência artificial com essa natureza teria? Voltando a um exemplo anterior, se você projetar uma inteligência artificial desenhada para conceder liberdade condicional a alguém, é bastante claro que os direitos desse sistema seriam quase nulos.

Mas as coisas ficam mais complicadas quando você chega a uma inteligência artificial que está realmente tentando entender a emoção humana. Porque, para fazer isso, a inteligência artificial precisa internalizar esse entendimento, já que nosso entendimento da moral e o nosso entendimento das considerações morais se fundamentam na nossa capacidade de perceber essas coisas diretamente por conta própria.

Então, quando você constrói um sistema gigante de caixa preta com a intenção de ser capaz de levar em conta coisas como as considerações morais e as ofensas, você não pode manter a ignorância total sobre o modo como ele está experimentando essas coisas. Porque ele está experimentando essas coisas. De alguma forma, de algum jeito, talvez metaforicamente. Mas há algo como a nossa experiência das considerações morais ocorrendo dentro do sistema, e, no minuto em que você tem isso, a questão dos direitos naturais se torna mais nebulosa. Porque, nesse ponto, o sistema não está apenas dando uma resposta “sim ou não” para uma determinada decisão. Ele está simulando uma pessoa inteira.

A questão então se torna: “Estamos prontos para lidar com as consequências da simulação de uma pessoa inteira? Estamos prontos para lidar com as considerações éticas que isso traz?”. Por analogia, tenho apontado para a moratória sobre a clonagem humana. Em todo o mundo, não temos feito clonagem humana porque as considerações morais se tornam muito complicadas muito rapidamente. Pode ser que uma moratória similar sobre a inteligência artificial semelhante à humana esteja na ordem do dia até que descubramos como queremos lidar com isso.

Fonte: https://www.ihu.unisinos.br/628234-o-chatgpt-tem-alma-uma-conversa-sobre-etica-catolica-e-inteligencia-artificial-com-blake-lemoine

Nenhum comentário:

Postar um comentário