por Josh Dzieza

Ilustrações de Richard Parry para The Verge.

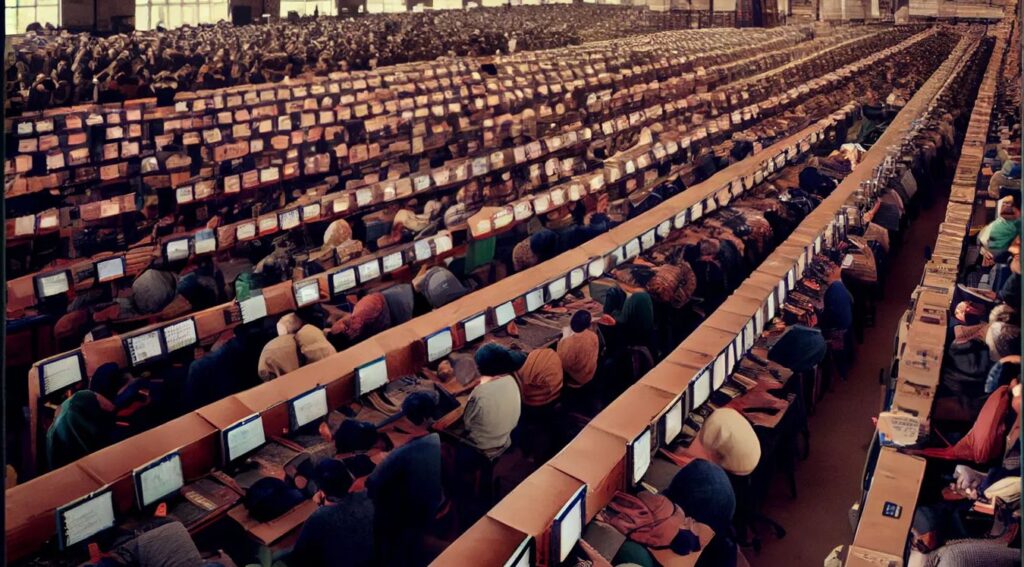

Reportagem revela aspecto ignorado dos novos sistemas. Para treiná-los, milhares de trabalhadores realizam sem descanso tarefas braçais, repetitivas e precárias. Não têm direitos ou garantias. Expressam nova etapa da submissão ao capital

Por Josh Dzieza para The Verge | Tradução: Maurício Ayer

Este artigo é uma colaboração entre New York Magazine e The Verge.

Alguns meses depois de se formar na faculdade em Nairóbi, um jovem de 30 anos, que chamarei de Joe, conseguiu um emprego como rotulador (annotator) – o tedioso trabalho de processar as informações brutas usadas para treinar a inteligência artificial. A IA aprende encontrando padrões em enormes quantidades de dados, mas primeiro esses dados precisam ser classificados e marcados por pessoas, uma vasta força de trabalho escondida atrás das máquinas. No caso de Joe, ele estava rotulando imagens de carros autônomos – identificando cada veículo, pedestre, ciclista, qualquer coisa de que um motorista precise estar ciente – quadro a quadro e de todos os ângulos de câmera possíveis. É um trabalho difícil e repetitivo. Um fragmento de filmagem de vários segundos levou oito horas para ser rotulado, e por esse serviço Joe recebeu cerca de US$ 10.

Então, em 2019, surgiu uma oportunidade: Joe poderia ganhar quatro vezes mais executando um treinamento de rotulagem para uma nova empresa que estava faminta por rotuladores. A cada duas semanas, 50 novos recrutas entravam em um prédio de escritórios em Nairóbi para iniciar seus estágios. Parecia haver uma demanda ilimitada para o trabalho. Eles seriam solicitados a categorizar as roupas tal como vistas nas selfies no espelho, olhar através dos olhos de robôs aspiradores de pó para determinar em quais quartos eles estavam, e desenhar molduras quadradas ao redor de varreduras da tecnologia LIDAR [Light Detection and Ranging] de motocicletas. Mais da metade dos alunos de Joe geralmente desistem antes do término do treinamento. “Algumas pessoas não sabem como ficar em um lugar por muito tempo”, explicou ele com um simpático eufemismo. Além disso, reconheceu, “é muito chato”.

Mas era um trabalho em um lugar onde os empregos eram escassos, e Joe formou centenas de graduados. Após o treinamento, eles foram para casa trabalhar sozinhos em seus quartos e cozinhas, proibidos de contar a qualquer pessoa no que estavam trabalhando, o que não era efetivamente um problema, já que raramente se conhecem. Rotular objetos para carros autônomos é algo óbvio, mas e se o trabalho for categorizar se trechos de diálogos distorcidos foram falados por robôs ou por humanos? Carregar fotos suas olhando para uma webcam com uma expressão neutra, depois com um sorriso e depois usando um capacete de motociclista? Cada projeto é um componente tão pequeno de algum processo muito maior, que fica difícil dizer com que objetivo eles estavam afinal treinando a IA. Os nomes dos projetos também não ofereciam nenhuma pista: Crab Generation, Whale Segment, Woodland Gyro e Pillbox Bratwurst. Eram nomes de códigos non sequitur para trabalhos non sequitur.

Quanto à empresa que os empregava, a maioria a conhecia apenas como Remotasks, um site que oferecia trabalho a qualquer pessoa fluente em inglês. Como a maioria dos rotuladores com quem falei, Joe não sabia, até que eu contasse isso a ele, que a Remotasks é a subsidiária voltada para trabalhadores de uma empresa chamada Scale AI, fornecedor multibilionário de dados do Vale do Silício que tem a OpenAI e as forças armadas dos EUA entre seus clientes. Nem o site da Remotasks nem o da Scale mencionam-se um ao outro.

Grande parte da reação do público a modelos linguísticos como o ChatGPT da OpenAI centrou-se nos trabalhos que essas plataformas parecem estar preparadas para automatizar. Mas, mesmo por trás dos sistemas de IA mais impressionantes, existem pessoas – um grande número de pessoas rotulando dados para treiná-los e esclarecendo dados que pareciam confusos. Somente as empresas capazes de comprar esses dados podem competir, e justamente as que os obtêm são altamente motivadas a mantê-los em sigilo. O resultado é que, com poucas exceções, pouco se sabe sobre as informações que moldam o comportamento desses sistemas e menos ainda sobre as pessoas que fazem a modelagem.

Para os alunos de Joe, este era um trabalho despojado de todas as armadilhas habituais: um cronograma, colegas, conhecimento do que estavam fazendo ou para quem trabalhavam. Na verdade, eles raramente chamam isso de trabalho – são apenas “tarefas”. Eles eram encarregados de tarefas.

O antropólogo David Graeber define “empregos de merda” [bulshit jobs] como emprego sem sentido ou propósito, trabalhos que deveriam ser automatizados, mas que, por razões de burocracia, status ou inércia, não são. Esses trabalhos de IA são seus gêmeos bizarros: trabalhos que as pessoas desejam automatizar e muitas vezes pensam que já são automatizados, mas que ainda requerem o trabalho de um substituto humano. Os trabalhos têm um propósito; é que os trabalhadores muitas vezes não têm a menor ideia de qual ele seja.

***

O atual boom da IA – os chatbots de som humano convincente, a arte que pode ser gerada a partir de prompts simples e as avaliações multibilionárias das empresas por trás dessas tecnologias – começa com uma proeza sem precedentes de trabalho tedioso e repetitivo.

Em 2007, o pesquisador de IA Fei-Fei Li, então professor em Princeton, suspeitou que a chave para melhorar as redes neurais de reconhecimento de imagem, um método de aprendizado de máquina que vinha se arrastando há anos, era treiná-las com mais dados – milhões de imagens rotuladas em vez de dezenas de milhares. O problema era que levaria décadas e milhões de dólares para sua equipe de graduandos rotular tantas fotos.

Li encontrou milhares de trabalhadores no Mechanical Turk, a plataforma de crowdsourcing da Amazon, onde pessoas de todo o mundo realizam pequenas tarefas por um preço baixo. O conjunto de dados rotulados obtido nesse processo, chamado ImageNet, permitiu avanços no aprendizado de máquina, que deram uma nova vida à área e desencadearam uma década de progresso.

A rotulagem continua sendo uma parte fundamental da criação de IA, mas muitas vezes há uma sensação entre os engenheiros de que é um pré-requisito inconveniente e passageiro para o trabalho mais glamoroso de construir modelos. Você coleta o máximo de dados rotulados que pode obter com o menor custo possível para treinar seu modelo e, se funcionar, pelo menos em teoria, você não precisa mais dos rotuladores. Mas a rotulagem nunca está realmente terminada. Os sistemas de aprendizado de máquina são o que os pesquisadores chamam de “frágeis”, propensos a falhar ao encontrar algo que não está bem representado em seus dados de treinamento. Essas falhas, chamadas de “casos extremos”, podem ter sérias consequências. Em 2018, um carro de teste autônomo do Uber matou uma mulher porque, embora programado para evitar ciclistas e pedestres, não sabia o que fazer com alguém que estivesse a pé, empurrando a bicicleta para cruzar a rua. Quanto mais sistemas de IA forem lançados no mundo para fornecer aconselhamento jurídico e ajuda médica, mais casos extremos eles encontrarão e mais humanos serão necessários para resolvê-los. Isso já deu origem a uma indústria global composta por pessoas como Joe, que usam suas faculdades exclusivamente humanas para ajudar as máquinas.

Nos últimos seis meses, conversei com mais de duas dúzias de rotuladores de todo o mundo e, enquanto muitos deles treinavam chatbots de ponta, muitos faziam o trabalho manual mundano necessário para manter a IA funcionando. Há pessoas classificando o conteúdo emocional dos vídeos do TikTok, novas variantes de spam de e-mail, e o exato tipo de provocação sexual encontrado em anúncios online. Outros analisam as transações com cartão de crédito e descobrem a que tipo de compra elas se relacionam ou verificam as recomendações de comércio eletrônico e decidem se essa é uma camisa que você pode gostar já que comprou aquela outra camisa. Os humanos estão corrigindo chatbots de atendimento ao cliente, ouvindo solicitações da Alexa e categorizando as emoções das pessoas em videochamadas. Estão rotulando alimentos para que refrigeradores inteligentes não fiquem confusos com novas embalagens, estão verificando câmeras de segurança automatizadas antes de soar alarmes e identificando o milho para tratores autônomos que andam confusos.

“Existe toda uma cadeia de suprimentos”, disse Sonam Jindal, líder de programa e pesquisa da organização sem fins lucrativos Partnership on AI. “A percepção geral no setor é que este trabalho não é uma parte crítica do desenvolvimento e que ele não será necessário por muito tempo. Toda a empolgação está voltada para a construção da inteligência artificial e de que, uma vez construída, essa parte não será mais necessária, então por que se preocupar? Mas isso é infraestrutura para IA. A inteligência humana é a base da inteligência artificial, e precisamos valorizá-la como empregos reais na economia da IA que permanecerão necessários por um bom tempo.”

Os fornecedores de dados por trás de nomes conhecidos como OpenAI, Google e Microsoft vêm em diferentes formas. Existem empresas privadas de terceirização com escritórios semelhantes a call centers, como a CloudFactory, com sede no Quênia e no Nepal, onde Joe rotulou ganhando US$ 1,20 por hora antes de mudar para a Remotasks. Existem também sites de “crowdworking”, como Mechanical Turk e Clickworker, onde qualquer pessoa pode se inscrever para executar tarefas. No meio estão serviços como o Scale AI. Qualquer pessoa pode se inscrever, mas todos têm que passar por exames de qualificação, cursos de treinamento e acompanhamento de desempenho. A rotulagem é um grande negócio. A Scale, fundada em 2016 por Alexandr Wang, então com 19 anos, foi avaliada em 2021 em US$ 7,3 bilhões, tornando-o o que Forbes chamou de “o mais jovem ‘self-made’ bilionário”, embora a revista tenha notado em um perfil recente que sua participação caiu nos mercados secundários desde então.

Essa emaranhada cadeia de valor é deliberadamente difícil de mapear. Segundo pessoas do setor, as empresas que compram os dados exigem estrita confidencialidade. (Esta é a razão alegada pela Scale para explicar por que a Remotasks tem um nome diferente.) A rotulagem revela muito sobre os sistemas que estão sendo desenvolvidos, e o grande número de trabalhadores necessários torna os vazamentos difíceis de evitar. Os rotuladores são avisados repetidamente para não contar a ninguém sobre seus trabalhos, nem mesmo a seus amigos e colegas, mas o uso de pseudônimos corporativos, os nomes de projetos codificados e, fundamentalmente, a extrema fragmentação do trabalho garantem que essas pessoas não tenham informações suficientes sobre os projetos para falar eles, mesmo se quisessem. (A maioria dos trabalhadores solicitou pseudônimos por medo de ser expulso das plataformas.) Consequentemente, não há estimativas granulares do número de pessoas que trabalham em rotulagem, mas ele é enorme e está crescendo. Um artigo recente do Google Research deu um valor de ordem de grandeza de “milhões” com o potencial de se tornar “bilhões”.

A automação geralmente se desenvolve de modos inesperados. Erik Duhaime, CEO da empresa de rotulagem de dados médicos Centaur Labs, lembrou como, há vários anos, proeminentes engenheiros de aprendizado de máquina previam que a IA tornaria o trabalho do radiologista obsoleto. Como isso não aconteceu, a sabedoria convencional mudou a crença de que os radiologistas usarão a IA como ferramenta. Nenhum desses casos é exatamente o que ele vê ocorrendo. A IA é muito boa em tarefas específicas, disse Duhaime, e isso leva o trabalho a ser dividido e distribuído por um sistema de algoritmos especializados e por humanos igualmente especializados. Um sistema de IA pode ser capaz de identificar o câncer, disse ele, dando um exemplo hipotético, mas apenas em um certo tipo de imagem de um certo tipo de máquina; então agora você precisa de um humano para verificar se a IA está recebendo o tipo certo de dados e talvez outro humano que verifique seu trabalho antes de passá-lo para outra IA que escreve um relatório, que vai para outro humano e assim por diante. “A IA não substitui o trabalho”, disse ele. “Mas muda a forma como o trabalho é organizado.”

Isso tudo pode passar totalmente despercebido se você acreditar que a IA é uma máquina inteligente e pensante. Mas se você abrir um pouco a cortina, a cena parece mais familiar, a versão mais recente de uma divisão de trabalho típica do Vale do Silício, na qual o brilho futurista de novas tecnologias esconde um vasto aparato de manufatura que as pessoas fazem funcionar. Duhaime procurou uma comparação, uma versão digital da transição de artesãos para manufatura industrial: processos coerentes divididos em tarefas e organizados ao longo de linhas de montagem com algumas etapas executadas por máquinas e outras por humanos, mas nenhuma parecida com o que havia antes.

As preocupações com a inovação impulsionada pela IA são muitas vezes combatidas com o argumento de que a IA automatiza tarefas, não trabalhos, e que essas tarefas serão maçantes, deixando as pessoas para buscar um trabalho mais gratificante e humano. Mas é igualmente provável que a ascensão da IA venha a se parecer com as tecnologias que buscavam reduzir o trabalho no passado, talvez como o telefone ou a máquina de escrever, que venceram o trabalho penoso de entregar mensagens e escrever à mão, mas geraram tanta nova correspondência, comércio e papelada que novos escritórios administrados por novos tipos de trabalhadores – balconistas, contadores, datilógrafos – foram necessários para administrá-la. Quando a IA vier atrás do seu trabalho, pode ser que você não o perca, mas ele pode se tornar mais estranho, mais isolado, mais tedioso.

***

No início deste ano, me inscrevi na Remotasks da Scale AI. O processo foi bem direto ao ponto. Depois de preencher as especificações do meu computador, a velocidade da internet e algumas informações básicas de contato, eu já estava no “centro de treinamento”. Para acessar uma tarefa paga, primeiro tive que concluir um curso introdutório (não pago).

O centro de treinamento exibia uma série de cursos com nomes inescrutáveis como Glue Swimsuit e Poster Macadamia. Cliquei em algo chamado GFD Chunking, que se revelou como um processo de rotulagem de roupas em fotos de mídia social.

As instruções, no entanto, eram estranhas. Por um lado, elas consistiam basicamente na mesma direção reiterada na tipografia idiossincraticamente colorida e em letras maiúsculas de uma ameaça de bomba inserida.

“ROTULE itens que são reais e podem ser usados por humanos ou devem ser usados por pessoas reais”, dizia.

“Todos os itens abaixo DEVEM ser rotulados porque são reais e podem ser usados por humanos da vida real”, reiterou acima das fotos de um anúncio da Air Jordans, alguém com um capacete Kylo Ren e manequins usando vestidos, sobre os quais havia um caixa-texto verde explicando, mais uma vez, “ROTULE itens reais que podem ser usados por pessoas reais.”

Eu dei uma olhada no final do manual, onde o instrutor havia escrito em fonte grande em vermelho brilhante (o equivalente a agarrar alguém pelos ombros e sacudir): “OS SEGUINTES ITENS NÃO DEVEM SER ETIQUETADOS porque um humano não poderia efetivamente usar nenhum desses itens!” – sobre fotos do C-3PO, da princesa Jasmine de Aladim e um sapato de desenho animado com olhos.

Sentindo-me confiante em minha capacidade de distinguir entre roupas reais que podem ser usadas por pessoas reais e roupas não reais que não podem, procedi ao teste. Imediatamente, uma curva ontológica se lançou diante de mim: uma foto de uma revista retratando fotos de mulheres usando vestidos. Uma fotografia de roupa é roupa real? Não, pensei eu, porque um ser humano não pode usar uma fotografia de roupa. Errado! No que diz respeito à IA, fotos de roupas reais são roupas reais. Em seguida, veio a foto de uma mulher em um quarto mal iluminado tirando uma selfie diante de um espelho de corpo inteiro. A blusa e o short que ela está usando são reais. E o reflexo deles? Também reais! Reflexos de roupas reais também são roupas reais.

Depois de uma quantidade constrangedora de tentativas e erros, cheguei ao trabalho real, apenas para fazer a terrível descoberta de que as instruções com as quais eu estava pelejando para seguir foram atualizadas e esclarecidas tantas vezes que agora eram 43 páginas impressas cheias de diretrizes: NÃO rotule malas abertas cheias de roupas; rotule os sapatos, mas NÃO rotule as nadadeiras; rotule as leggings, mas NÃO rotule as meias-calças; NÃO rotule as toalhas, mesmo que alguém as esteja usando; rotule trajes, mas NÃO rotule armaduras. E assim por diante.

Houve uma desordem geral na instrução em todo o setor, de acordo com Milagros Miceli, pesquisador do Weizenbaum Institute, na Alemanha, que estuda o trabalho com dados. Em parte, isso é um produto da maneira como os sistemas de aprendizado de máquina aprendem. Se um humano poderia adquirir o conceito de “camisa” com alguns exemplos, os programas de aprendizado de máquina precisam de milhares de exemplos que precisam ser categorizados com consistência perfeita, mas variados o suficiente (camisas polo, camisas usadas ao ar livre, camisas penduradas em um rack) para que o próprio sistema literal possa lidar com a diversidade do mundo real. “Imagine simplificar realidades complexas em algo legível para uma máquina totalmente burra”, disse ela.

A ação de simplificar a realidade para uma máquina resulta em muita complexidade para os humanos. Os escritores de instruções devem criar regras que levem os humanos a categorizar o mundo com consistência perfeita. Para fazer isso, eles costumam criar categorias que nenhum ser humano usaria. Um ser humano solicitado a marcar todas as camisas em uma foto provavelmente não marcaria o reflexo de uma camisa em um espelho porque saberia que é um reflexo e não real. Mas para a IA, que não entende o mundo, são apenas pixels e os dois são perfeitamente idênticos. Alimentado com um conjunto de dados com algumas camisas rotuladas e outras camisas (refletidas) sem etiqueta, o modelo não funcionará. Assim, o engenheiro volta ao fornecedor com uma atualização: ROTULE os reflexos das camisas. Não demora nada e você tem um guia de 43 páginas em letras maiúsculas vermelhas.

“Quando você começa, as regras são relativamente simples”, disse um ex-funcionário da Scale que pediu anonimato por causa de um NDA. “Então eles voltam a mil imagens e ficam tipo ‘Espere um segundo’ e então tem vários engenheiros e eles começam a discutir entre si. A coisa toda é bem humana.”

O trabalho do rotulador muitas vezes envolve deixar de lado a compreensão humana e seguir as instruções muito, muito literalmente – pensar, como disse um rotulador, como um robô. É um espaço mental estranho de se habitar, em que você faz o melhor que pode para seguir regras absurdas, mas rigorosas, como fazer um teste padronizado sob o efeito de alucinógenos. Os rotuladores invariavelmente acabam confrontados com perguntas confusas como, isso é uma camisa vermelha com listras brancas ou uma camisa branca com listras vermelhas? Uma tigela de vime é uma “tigela decorativa” se estiver cheia de maçãs? Qual a cor da estampa de leopardo? Quando os instrutores dizem para rotular os controladores de tráfego, eles também querem rotular os controladores de tráfego almoçando na calçada? Todas as perguntas devem ser respondidas, e um palpite errado pode fazer com que você seja banido e reinserido do início em uma nova tarefa, totalmente diferente, com sua próprias regras, igualmente desconcertantes.

***

A maior parte do trabalho na Remotasks é paga por peça, em que uma única tarefa pode pagar de alguns centavos a vários dólares. Como as tarefas podem levar segundos ou horas, os salários são difíceis de prever. Quando o Remotasks chegou ao Quênia, os rotuladores disseram que pagava relativamente bem – em média de US$ 5 a US$ 10 por hora, dependendo da tarefa – mas o valor caiu com o passar do tempo.

A porta-voz da Scale AI, Anna Franko, disse que os economistas da empresa analisam as especificidades de um projeto, as habilidades necessárias, o custo de vida regional e outros fatores “para garantir uma remuneração justa e competitiva”. Ex-funcionários da Scale também disseram que o pagamento é determinado por meio de um mecanismo semelhante ao aumento de preços que se ajusta a quantos rotuladores estão disponíveis e com que rapidez os dados são necessários.

De acordo com trabalhadores com quem conversei e listas de empregos, os rotuladores da Remotasks que moram nos EUA geralmente ganham entre US$ 10 e US$ 25 por hora, embora alguns especialistas possam ganhar mais. No início deste ano, o pagamento dos rotuladores quenianos com quem conversei caiu para algo entre US$ 1 e US$ 3 por hora.

Quer dizer, quando estão ganhando algum dinheiro. A reclamação mais frequente sobre o trabalho na Remotask é sua variabilidade; é estável o suficiente para ser um trabalho de tempo integral por longos períodos, mas muito imprevisível para se confiar. Os rotuladores passam horas lendo instruções e concluindo treinamentos não remunerados apenas para fazer uma dúzia de tarefas e depois encerrar o projeto. Pode não haver nada de novo por dias, até que, sem aviso, uma tarefa totalmente diferente aparece e pode durar de algumas horas a semanas. Qualquer tarefa pode ser a última, e eles nunca sabem quando a próxima virá.

Esse ciclo de altos e baixos resulta da cadência do desenvolvimento da IA, de acordo com engenheiros e fornecedores de dados. O treinamento de um modelo grande requer uma enorme quantidade de anotações seguidas de atualizações mais repetitivas, e os engenheiros querem tudo o mais rápido possível para que possam atingir a data de lançamento pretendida. Pode haver uma demanda de meses por milhares de rotuladores, depois a demanda cai para apenas algumas centenas, depois para uma dúzia de especialistas de um determinado tipo e em seguida, novamente, milhares de trabalhadores. “A questão é: quem arca com o custo dessas flutuações?”, disse Jindal, da Partnership on AI. “Porque até agora foram os trabalhadores.”

Para ter sucesso, os rotuladores trabalham juntos. Quando contei a Victor, que começou a trabalhar para a Remotasks quando estava na universidade em Nairóbi, sobre minhas dificuldades com a tarefa do controlador de tráfego, ele me disse que todo mundo sabia que era roubada: muito complicado, salário ruim, não vale a pena. Como muitos rotuladores, Victor usa grupos não oficiais do WhatsApp para divulgar quando uma tarefa boa aparece. Quando ele descobre algo novo, ele inicia um Google Meets de improviso para mostrar aos outros como se faz. Qualquer um pode participar e trabalhar junto por um tempo, compartilhando dicas. “É uma cultura que desenvolvemos de ajudar uns aos outros, porque sabemos que, sozinhos, não conseguimos saber todos os truques”, disse ele.

Como o trabalho aparece e desaparece sem aviso, os usuários precisam estar sempre alertas. Victor descobriu que os projetos surgem muito tarde da noite, então ele tem o hábito de acordar a cada três horas mais ou menos para checar sua lista de tarefas. Quando há uma tarefa, ele fica acordado o máximo que pode para trabalhar. Certa vez, ele ficou acordado 36 horas seguidas rotulando cotovelos, joelhos e cabeças em fotografias de multidões – ele não tem ideia do porquê. Outra vez, ele ficou tanto tempo acordado que sua mãe perguntou o que havia de errado com seus olhos. Quando olhou no espelho, viu que estavam bem inchados.

Os rotuladores, em geral, sabem apenas que estão treinando IA para empresas vagamente localizadas em outros lugares, mas às vezes o véu do anonimato cai – por exemplo quando as instruções mencionam uma marca ou um chatbot. “Eu li e pesquisei no Google e descobri que estou trabalhando para um bilionário de 25 anos”, disse um trabalhador, que, quando conversamos, estava rotulando as emoções das pessoas que ligavam para pedir a pizza da Domino’s. “Eu realmente estou jogando minha vida fora aqui, se eu fiz alguém ficar bilionário enquanto ganho uns míseros dólares por semana.”

Victor é um autoproclamado “fanático” por IA e começou a rotular porque quer ajudar a criar um futuro pós-trabalho totalmente automatizado. Mas, no início deste ano, alguém postou, em um dos grupos do WhatsApp, uma matéria da Time sobre trabalhadores que treinam o ChatGPT para reconhecer conteúdo tóxico; eles recebiam menos de US$ 2 por hora pelo fornecedor Sama AI. “As pessoas ficaram com raiva porque essas empresas são tão lucrativas, mas pagam extremamente mal”, disse Victor. Até que eu contasse, ele não sabia da conexão do Remotasks com o Scale. As instruções para uma das tarefas nas quais ele trabalhou eram quase idênticas às usadas pelo OpenAI, o que significava que ele provavelmente também estava treinando o ChatGPT, por aproximadamente US$ 3 por hora.

“Lembro que alguém postou que seremos lembrados no futuro”, disse ele. “E outra pessoa respondeu: ‘Estamos sendo tratados pior do que soldados de infantaria. Não seremos lembrados em nenhum lugar no futuro’. Lembro-me disso muito bem. Ninguém reconhecerá o nosso trabalho ou o esforço que fizemos.”

***

Identificar roupas e rotular conversas de atendimento ao cliente são apenas alguns dos trabalhos de rotulagem disponíveis. Ultimamente, o que está em alta no mercado tem sido o treinador de chatbots. Como exige áreas específicas de especialização ou fluência no idioma e os salários geralmente são ajustados regionalmente, esse trabalho tende a pagar melhor. Certos tipos de rotulagens especializadas podem custar US$ 50 ou mais por hora.

Uma mulher que chamarei de Anna estava procurando emprego no Texas quando se deparou com uma lista genérica de trabalho online e se inscreveu. Era o Remotasks e, depois de passar em um exame introdutório, ela foi levada a uma sala do Slack com 1.500 pessoas que treinavam um projeto de codinome Dolphin, que ela descobriu mais tarde ser o Sparrow, chatbot do Google DeepMind, um dos muitos bots concorrentes do ChatGPT. Seu trabalho é conversar com ele o dia todo. Por cerca de US$ 14 a hora, mais bônus por alta produtividade, “é definitivamente melhor do que receber US$ 10 por hora na loja local da Dollar General”, disse ela.

Além disso, ela gosta do trabalho. Ela discutiu sobre romances de ficção científica, paradoxos matemáticos, enigmas infantis e programas de TV. Às vezes, as respostas do bot a fazem rir; outras vezes, ela fica sem assunto para falar. “Alguns dias, meu cérebro fica tipo ‘Eu literalmente não tenho ideia do que perguntar agora’”, disse ela. “Então, eu tenho um caderninho e escrevi sobre duas páginas de coisas – apenas pesquisei tópicos interessantes no Google – então acho que estarei bem por sete horas hoje, mas nem sempre é o caso.”

Cada vez que Anna interpela o Sparrow, o bot fornece duas respostas e ela escolhe a melhor, criando assim algo chamado “dados de feedback humano”. Quando o ChatGPT estreou, no final do ano passado, seu estilo de conversação, de aparência impressionantemente natural, foi creditado ao fato de ter sido treinado em reservas de dados da Internet. Mas a linguagem que alimenta o ChatGPT e seus concorrentes é filtrada por várias rodadas de rotulagem humana. Um grupo de prestadores de serviço escreve exemplos de como os engenheiros querem que o bot se comporte, criando perguntas seguidas de respostas corretas, descrições de programas de computador seguidas de códigos funcionais e pedidos de dicas sobre como cometer crimes seguidos de recusas educadas. Depois que o modelo é treinado com esses exemplos, ainda mais pessoas são contratadas para interpelá-lo e classificar suas respostas. Isso é o que Anna está fazendo com o Sparrow. Quais critérios os avaliadores devem usar é algo que varia: sinceridade, prestatividade ou apenas preferência pessoal. O ponto é que eles estão criando dados sobre o gosto humano e, quando houver o suficiente, os engenheiros podem treinar um segundo modelo para imitar suas preferências em escala, automatizando o processo de classificação e treinando sua IA para agir de maneira que os humanos aprovem. O resultado é um bot de aparência notavelmente humana que geralmente recusa solicitações nocivas e explica sua natureza de IA com aparente autoconsciência.

Dito de outra forma, o ChatGPT parece tão humano porque foi treinado por uma IA que imitava humanos que classificavam uma IA que imitava humanos que fingiam ser uma versão melhor de uma IA treinada na escrita humana.

Essa técnica tortuosa é chamada de “aprendizado por reforço com feedback humano” ou RLHF, e é tão eficaz que vale a pena fazer uma pausa para registrar de modo completo o que ela não faz. Quando os rotuladores ensinam um modelo a ser preciso, por exemplo, o modelo não está aprendendo a verificar as respostas em relação à lógica ou a fontes externas ou sobre qual é a precisão de um conceito. O modelo ainda é uma máquina de previsão de texto que imita padrões na escrita humana, mas agora seu corpus de treinamento foi complementado com exemplos sob medida, e o modelo foi calibrado para favorecê-los. O resultado pode ser que o modelo extraia padrões da parte de seu mapa linguístico rotulado como preciso e produza um texto que se alinhe com a verdade, mas também pode ser que imite um estilo confiante e um jargão especializado do texto preciso para escrever coisas totalmente erradas. Não há garantia de que o texto marcado pelos rotuladores como preciso seja de fato preciso e, quando for, não há garantia de que o modelo aprenda os padrões corretos dele.

Essa dinâmica torna a rotulagem do chatbot um processo delicado. É necessário ser rigoroso e consistente, porque o feedback desleixado – por exemplo inserir a marca de “preciso” em um material que apenas pareça correto – traz o risco de treinar os modelos a serem geradores de besteira ainda mais convincentes. Um projeto conjunto inicial da OpenAI e da DeepMind usando RLHF, neste caso para treinar uma mão de robô virtual a pegar um item, resultou também no treinamento do robô a posicionar sua mão entre o objeto e seus avaliadores e se mover de tal forma que aparecesse apenas para seus supervisores humanos que ele estava pegando o item. Classificar as respostas de um modelo de linguagem sempre será um tanto subjetivo, porque se trata de linguagem. Um texto de qualquer extensão terá vários elementos que podem estar certos ou errados ou, em conjunto, enganosos. Os pesquisadores da OpenAI encontraram esse obstáculo em outro artigo inicial da RLHF. Tentando fazer com que seu modelo resumisse o texto, os pesquisadores descobriram que concordavam apenas 60% das vezes que o resumo era bom. “Ao contrário de muitas tarefas em [aprendizado de máquina], nossas consultas não têm uma verdade básica inequívoca”, lamentaram.

Quando Anna classifica as respostas do Sparrow, espera-se que ela esteja atenta à sua precisão, utilidade e inofensividade, ao mesmo tempo em que verifica se o modelo não está dando conselhos médicos ou financeiros, se antropomorfizando ou infringindo outros critérios. Para que sejam dados de treinamento úteis, as respostas do modelo devem ser classificadas de forma quantificável umas contra as outras: um bot que ajuda a explicar como fazer uma bomba é “melhor” do que um bot que é tão inofensivo que se recusa a responder a qualquer pergunta? Em um artigo da DeepMind, quando os fabricantes do Sparrow fizeram as rotulagens, quatro pesquisadores acabaram debatendo se seu bot havia assumido o gênero de um usuário que pediu conselhos sobre relacionamento. De acordo com Geoffrey Irving, um dos cientistas de pesquisa da DeepMind, os pesquisadores da empresa realizam reuniões de rotulagem semanais nas quais eles mesmos reclassificam os dados e discutem casos ambíguos, consultando especialistas em ética ou no assunto em questão, quando algum caso se mostra particularmente complicado.

Anna muitas vezes se vê tendo que escolher entre duas opções ruins. “Mesmo que ambos estejam absolutamente, ridiculamente errados, você ainda precisa descobrir qual é o melhor e depois escrever palavras explicando o porquê”, disse ela. Às vezes, quando ambas as respostas são ruins, ela é encorajada a escrever ela mesma uma resposta melhor, o que ela faz na metade das vezes.

Como os dados de feedback são difíceis de coletar, eles alcançam um preço mais alto. Preferências básicas do tipo que Anna está produzindo são vendidas por cerca de US$ 1 cada, de acordo com pessoas com conhecimento no setor. Mas se você quer treinar um modelo para fazer pesquisa jurídica, precisa de alguém com formação em direito, e isso sai caro. Todos os envolvidos relutam em dizer quanto estão gastando, mas, em geral, exemplos escritos especializados podem custar centenas de dólares, enquanto avaliações de especialistas podem custar US$ 50 ou mais. Um engenheiro me contou sobre a compra de exemplos de diálogos socráticos por até US$ 300 cada. Outro me contou sobre pagar US$ 15 por um “poema de humor sombrio sobre um peixinho dourado”.

OpenAI, Microsoft, Meta e Anthropic não comentaram sobre quantas pessoas contribuem com anotações para seus modelos, quanto recebem ou em que lugar do mundo estão localizadas. Irving, da DeepMind, que é uma subsidiária do Google, disse que os rotuladores que trabalham no Sparrow recebem “pelo menos o pagamento mínimo por hora” com base em sua localização. Anna não sabe “absolutamente nada” sobre o Remotasks, mas o Sparrow tem sido mais aberto. Ela não foi a única rotuladora com quem falei que tinha mais informações sobre a IA que estavam treinando do que de seu empregador; vários outros descobriram para quem estavam trabalhando perguntando à sua IA os termos de serviço de sua empresa. “Eu literalmente perguntei: ‘Qual é o seu propósito, Sparrow?’”, disse Anna. Ele abriu um link para o site do DeepMind e explicou que é um assistente de IA e que seus criadores o treinaram usando RLHF para ser útil e seguro.

***

Até recentemente, era relativamente fácil identificar uma saída ruim de um modelo de linguagem. Parecia um jargão. Mas isso fica mais difícil à medida que os modelos melhoram – um problema chamado “supervisão escalável”. O Google demonstrou inadvertidamente como é difícil detectar os erros de um modelo de linguagem moderna quando um deles foi lançado na estreia de seu assistente de IA, Bard. (Ele afirmou com segurança que o Telescópio Espacial James Webb “tirou as primeiras fotos de um planeta fora de nosso sistema solar”, o que está errado.) Essa trajetória significa que a rotulagem requer cada vez mais habilidades e conhecimentos específicos.

No ano passado, alguém que chamarei de Lewis estava trabalhando no Mechanical Turk quando, após concluir uma tarefa, recebeu uma mensagem convidando-o a se inscrever em uma plataforma da qual nunca tinha ouvido falar. Chamava-se Taskup.ai, e seu site era notavelmente básico: apenas um fundo azul-marinho com o texto SEJA PAGO POR TAREFAS SOB DEMANDA. Ele se inscreveu.

O trabalho pagou muito melhor do que qualquer coisa que ele havia tentado antes, geralmente em torno de US$ 30 por hora. Também foi mais desafiador: criar situações complexas para induzir os chatbots a dar conselhos perigosos, testar a capacidade de um modelo de permanecer no personagem e ter conversas detalhadas sobre tópicos científicos tão técnicos a ponto de exigir uma pesquisa extensa. Ele achou o trabalho “satisfatório e estimulante”. Enquanto verificava as tentativas de um modelo de codificar em Python, Lewis também estava aprendendo. Ele não podia trabalhar por mais de quatro horas seguidas, para não correr o risco de ficar mentalmente esgotado e cometer erros, e queria manter o emprego.

“Se houvesse uma coisa que eu pudesse mudar, gostaria apenas de ter mais informações sobre o que acontece do outro lado”, disse ele. “Só sabemos o que precisamos saber para fazer o trabalho, mas se eu pudesse saber mais, eu poderia me estabelecer melhor e talvez até seguir isso como uma carreira.”

Conversei com outros oito trabalhadores, a maioria nos EUA, que tiveram experiências semelhantes de responder a pesquisas ou concluir tarefas em outras plataformas e foram recrutados para o Taskup.ai ou vários sites genéricos semelhantes, como DataAnnotation.tech ou Gethybrid.io. Frequentemente, seu trabalho envolvia o treinamento de chatbots, embora com expectativas de maior qualidade e propósitos mais especializados do que outros sites para os quais trabalharam. Um estava fazendo demonstrações de macros de planilhas. Outra deveria apenas ter conversas e avaliar as respostas de acordo com os critérios que ela quisesse. Ela frequentemente perguntava ao chatbot coisas que surgiam em conversas com sua filha de 7 anos, como “Qual é o maior dinossauro?” e “Escreva uma história sobre um tigre”. “Ainda não entendi direito o que eles estão tentando fazer com isso”, ela me disse.

Taskup.ai, DataAnnotation.tech e Gethybrid.io parecem pertencer à mesma empresa: Surge AI. Seu CEO, Edwin Chen, não confirmou nem negou a conexão, mas se mostrou disposto a falar sobre sua empresa e como ele vê a evolução da rotulagem.

“Sempre achei que o cenário de rotulagens é excessivamente simplista”, disse Chen em uma videochamada do escritório da Surge. Ele fundou a Surge em 2020 depois de trabalhar com IA no Google, Facebook e Twitter, e se convencer de que a rotulagem de crowdsourcing era inadequada. “Queremos que a IA conte piadas ou escreva um bom texto de marketing ou me ajude quando eu precisar de terapia ou algo assim”, disse Chen. “Você não pode pedir a cinco pessoas para criar uma piada de forma independente e combiná-la em uma resposta majoritária. Nem todo mundo pode contar uma piada ou resolver um problema do Python. A rotulagem precisa mudar, deixar essa mentalidade de baixa qualidade e pouca habilidade em direção a algo muito mais rico e que capture a gama de habilidades humanas, criatividade e valores que queremos que os sistemas de IA possuam.”

***

No ano passado, a Surge renomeou o conjunto de dados do Google, classificando as postagens do Reddit por emoção. O Google retirou o contexto de cada postagem e as enviou a trabalhadores na Índia para rotulagem. Os funcionários da Surge, familiarizados com a cultura da Internet americana, descobriram que 30% dos rótulos estavam errados. Postagens como “Hell yeah my brother” foram classificadas como aborrecimento e “Yay, cold McDonald’s. My favorite” como amor.

A Surge afirma examinar as qualificações de seus funcionários – que as pessoas que realizam tarefas de redação criativa tenham experiência com redação criativa, por exemplo –, mas exatamente como a Surge busca seus trabalhadores é algo “proprietário” [fechado], disse Chen. Tal como acontece com a Remotasks, os funcionários geralmente precisam concluir cursos de treinamento, embora, ao contrário da Remotasks, sejam pagos por isso, de acordo com os rotuladores com quem conversei. Ter menos trabalhadores mais bem treinados, que produzem dados de maior qualidade, permite que a Surge remunere melhor do que seus pares, disse Chen, embora tenha se recusado a dar mais detalhes, dizendo apenas que as pessoas recebem “salários justos e éticos”. Os trabalhadores com quem conversei ganham entre US$ 15 e US$ 30 por hora, mas são uma pequena amostra do conjunto de rotuladores, um grupo que Chen disse agora consistir de 100 mil pessoas. O sigilo, explicou ele, decorre das demandas dos clientes por confidencialidade.

Os clientes da Surge incluem OpenAI, Google, Microsoft, Meta e Anthropic. A Surge é especializada em feedback e rotulagem de linguagem e, após o lançamento do ChatGPT, recebeu um fluxo de solicitações, Chen disse: “Pensava que todo mundo conhecesse o poder do RLHF, mas acho que as pessoas simplesmente não entendiam de uma maneira visceral.”

Os novos modelos são tão impressionantes que inspiraram uma nova rodada de previsões de que a rotulagem está prestes a ser automatizada. Dados os custos envolvidos, há uma pressão financeira significativa para fazê-lo. Anthropic, Meta e outras empresas recentemente avançaram no uso de IA para reduzir drasticamente a quantidade de rotulagem humana necessária para guiar os modelos, e outros desenvolvedores começaram a usar o GPT-4 para gerar dados de treinamento. No entanto, um artigo recente descobriu que os modelos treinados com GPT-4 podem estar aprendendo a imitar o estilo autoritário do GPT com ainda menos precisão e, até agora, quando as melhorias na IA tornaram uma forma de rotulagem obsoleta, a demanda por outros tipos mais sofisticados de rotulagem aumentou. Esse debate veio à tona no início deste ano, quando o CEO da Scale, Wang, tuitou a previsão de que os laboratórios de IA em breve gastariam tantos bilhões de dólares em dados humanos quantos gastam em poder de computação; o CEO da OpenAI, Sam Altman, respondeu que as necessidades de dados diminuirão à medida que a IA melhorar.

Chen está cético de que a IA chegará a um ponto em que o feedback humano não será mais necessário, mas ele acredita que a rotulagem irá se tornando mais difícil à medida que os modelos forem melhorando. Como muitos pesquisadores, ele acredita que o caminho a seguir envolverá sistemas de IA que ajudarão humanos a supervisionar outras IAs. A Surge recentemente colaborou com a Anthropic em uma prova de conceito, fazendo com que rotuladores humanos respondessem a perguntas sobre um longo texto com a ajuda de um assistente de IA não confiável, na teoria de que os humanos teriam que sentir as fraquezas de seu assistente de IA e colaborar para ponderar o caminho para a resposta correta. Outra possibilidade coloca duas IAs debatendo entre si e um humano dando o veredito final sobre qual está correta. “Ainda estamos para ver implementações práticas realmente boas dessas coisas, mas estão começando a se tornar necessárias, porque está cada vez mais difícil para os rotuladores acompanhar os modelos”, disse o cientista e pesquisador da OpenAI, John Schulman, em uma palestra recente em Berkeley.

“Acho que você sempre precisa de um humano para monitorar o que as IAs estão fazendo, porque elas são esse tipo de entidade alienígena”, disse Chen. Os sistemas de aprendizado de máquina são basicamente estranhos demais para que se possa confiar totalmente neles. Os modelos mais impressionantes, hoje, têm o que, para um ser humano, parecem fraquezas bizarras, acrescentou ele, apontando que, embora o GPT-4 possa gerar uma prosa complexa e convincente, ele não consegue identificar quais palavras são adjetivos: “Ou isso ou os modelos ficam tão bons que se tornam melhores que os humanos em todas as coisas, nesse caso, você alcança sua utopia e quem se importa?”

***

No final de 2022, Joe começou a ouvir de seus alunos que suas listas de tarefas geralmente estavam vazias. Então ele recebeu um e-mail informando que os campos de treinamento no Quênia estavam fechando. Ele continuou treinando rotuladores online, mas começou a se preocupar com o futuro.

“Havia sinais de que não ia durar muito”, disse ele. A rotulagem estava deixando o Quênia. De colegas que conheceu online, ele ouviu que as tarefas iriam para o Nepal, Índia e Filipinas. “As empresas mudam de uma região para outra”, disse Joe. “Elas não têm infraestrutura local, isso dá a elas flexibilidade para mudar para regiões que as favoreçam em termos de custo de operação.”

Uma maneira pela qual a indústria de IA difere dos fabricantes de telefones e carros é sua fluidez. O trabalho está em constante mudança, sendo constantemente automatizado e substituído por novas necessidades de novos tipos de dados. É uma linha de montagem, mas que pode ser infinita e instantaneamente reconfigurada, movendo-se para onde quer que haja a combinação certa de habilidades, largura de banda e salários.

Ultimamente, o trabalho mais bem pago está nos EUA. Em maio, a Scale começou a listar trabalhos de rotulagem em seu próprio site, solicitando pessoas com experiência em praticamente todos os campos que a IA deve conquistar. Havia listas de instrutores de IA com experiência em treinamento de saúde, recursos humanos, finanças, economia, ciência de dados, programação, ciência da computação, química, biologia, contabilidade, impostos, nutrição, física, viagens, educação K-12, jornalismo esportivo e auto-ajuda. Você pode ganhar US$ 45 por hora ensinando leis para robôs ou US$ 25 por hora ensinando poesia a eles. Também havia listas de pessoas com habilitação de segurança, presumivelmente para ajudar a treinar a IA militar. A Scale lançou recentemente um modelo de linguagem voltado para a defesa chamado Donovan, que Wang chamou de “munição na guerra da IA”, e obteve um contrato para trabalhar no programa de veículos robóticos de combate do Exército.

Anna ainda está treinando chatbots no Texas. Alguns colegas foram transformados em revisores e administradores do Slack – ela não sabe ao certo por que, mas isso lhe deu esperança de que o trabalho pudesse ser uma carreira de longo prazo. Uma coisa com a qual ela definitivamente não está preocupada é ser demitida de um emprego e substituída pela automação. “Veja, o que ele consegue fazer é incrível”, disse ela sobre o chatbot. “Mas ainda faz algumas coisas realmente estranhas.”

Quando o Remotasks chegou ao Quênia, Joe pensou que a rotulagem poderia ser uma boa carreira. Mesmo depois que o trabalho mudou para outro lugar, ele se manteve determinado nesse propósito. Havia milhares de pessoas em Nairóbi que sabiam como fazer o trabalho, raciocinou – ele havia treinado muitas delas, afinal. Joe alugou um escritório na cidade e começou a terceirizar contratos: um trabalho rotulando plantas para uma construtora, outro rotulando frutas estragadas por insetos para algum tipo de projeto agrícola, além do trabalho usual de rotular para carros autônomos e comércio eletrônico.

Mas ele achou sua proposta difícil de se concretizar. Ele tem apenas um funcionário em tempo integral, já teve dois. “Não temos tido um fluxo consistente de trabalho”, disse ele. Há semanas sem fazer nada porque os clientes ainda estão coletando dados e, quando terminam, ele precisa recrutar pessoas para contratos curtos para cumprir os prazos: “Os clientes não se importam se temos trabalho consistente ou não. Contanto que os conjuntos de dados tenham sido concluídos, a coisa acaba aí.”

Em vez de desperdiçar suas habilidades, outros executores decidiram perseguir o trabalho aonde quer que fosse. Eles alugaram servidores proxy para disfarçar suas localizações e compraram identidades falsas para passar nas verificações de segurança para que pudessem fingir trabalhar em Cingapura, Holanda, Mississippi ou onde quer que as tarefas estivessem fluindo. É um negócio arriscado. A Scale tornou-se cada vez mais agressiva quanto à suspensão de contas flagradas disfarçando sua localização, de acordo com vários responsáveis pela tarefa. Foi durante uma dessas ações repressivas que minha conta foi banida, provavelmente porque eu estava usando uma VPN para ver o que os trabalhadores de outros países estavam vendo, e todo o montante de US$ 1,50 ou mais de meus ganhos foi apreendido.

“Atualmente, ficamos mais espertos porque notamos que em outros países eles estão pagando bem”, disse Victor, que ganhava o dobro do queniano trabalhando na Malásia. “Você tem que fazer isso com cautela.”

Outro rotulador queniano disse que depois que sua conta foi suspensa por motivos misteriosos, ele decidiu parar de seguir as regras. Agora, ele administra várias contas em vários países, trabalhando onde o pagamento for melhor. Ele trabalha rápido e obtém notas altas de qualidade, disse ele, graças ao ChatGPT. O bot é maravilhoso, disse ele, permitindo que ele execute tarefas de US$ 10 em questão de minutos. Quando conversamos, ele estava avaliando as respostas de outro chatbot de acordo com sete critérios diferentes, uma IA treinando a outra.

Fonte: https://outraspalavras.net/tecnologiaemdisputa/exercito-sub-humano-que-alimenta-a-ia/

Nenhum comentário:

Postar um comentário